반응형

Pre-Trained Language Model - 미리 학습된 언어모델

💡 언어 모델(Language Model)

→ 단어 시퀀스에 부여하는 모델 (단어 시퀀스를 입력받아 해당 시퀀스가 얼마나 그럴듯한지 확률을 출력으로 하는 모델)

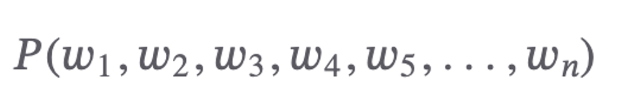

- 문장에서 i번째로 등장하는 단어를 𝑤n 이렇게 표기하면 n번째로 등장하는 언어모델에 등장할 확률 (수식 1)

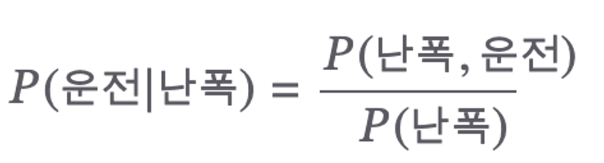

- ex) 난폭이라는 단어 등장후에 운전이라는 단어가 나타날 확률? → 조건부 확률 이라고 한다.

조건부 확률 표기시

- 결과가 되는 사건(운전)을 앞에, 조건이 되는 사건(난폭)은 뒤에 쓴다

- 조건이 되는 사건이 우변 분자의 일부, 그리고 우변 분모를 구성하고 있음을 볼 수 있음

= 이는 결과가 되는 사건(운전)은 조건이 되는 사건(난폭)의 영향을 받아 변한다는 개념을 내포

- 결합확률과 조건부 확률 사이에는 밀접한 관련이 있음

- 결합 확률과 조건부 확률 사이의 관계

결합 확률과 조건부 확률 사이의 관계

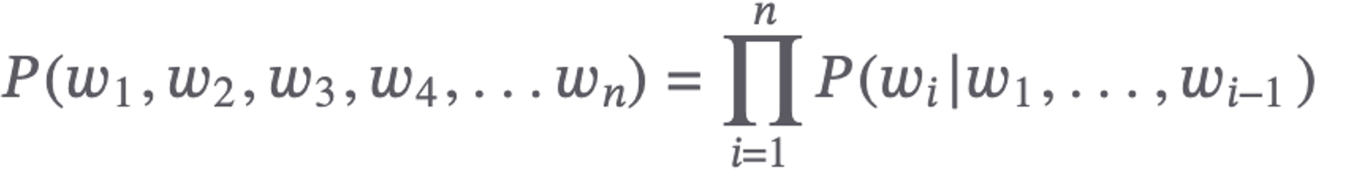

단어 3개가 동시에 등장하려면, 아래 3개 사건(event) 이 동시에 일어나야 한다는 말이 된다.

- 첫번째 단어(𝑤1)가 등장

- 첫번째 단어(𝑤1)가 등장한 후 두번째 단어(𝑤2)가 등장

- 첫번째 단어(𝑤1)와 두번째 단어(𝑤2 )가 등장한 후 세번째 단어(𝑤3)가 등장

- 전체 단어 시퀀스가 나타날 확률 (왼쪽 수식) = 이전 단어들이 주어졌을때 다음 단어가 등장할 확률

이것 때문에 언어 모델을 이전 단어들이 주어졌을때 다음 난어가 나타날 확률을 부여하는 모델

순방향 언어모델

조건부 확률의 정의에 따라 수식1의 조건부수식의 좌변과 우변이 같다는 사실을 알고 있으므로 언어 모델의 계산 로직을 이전 단어들(context)가 주어졌을 때 다음 단어를 맞추는것이 가능하다.

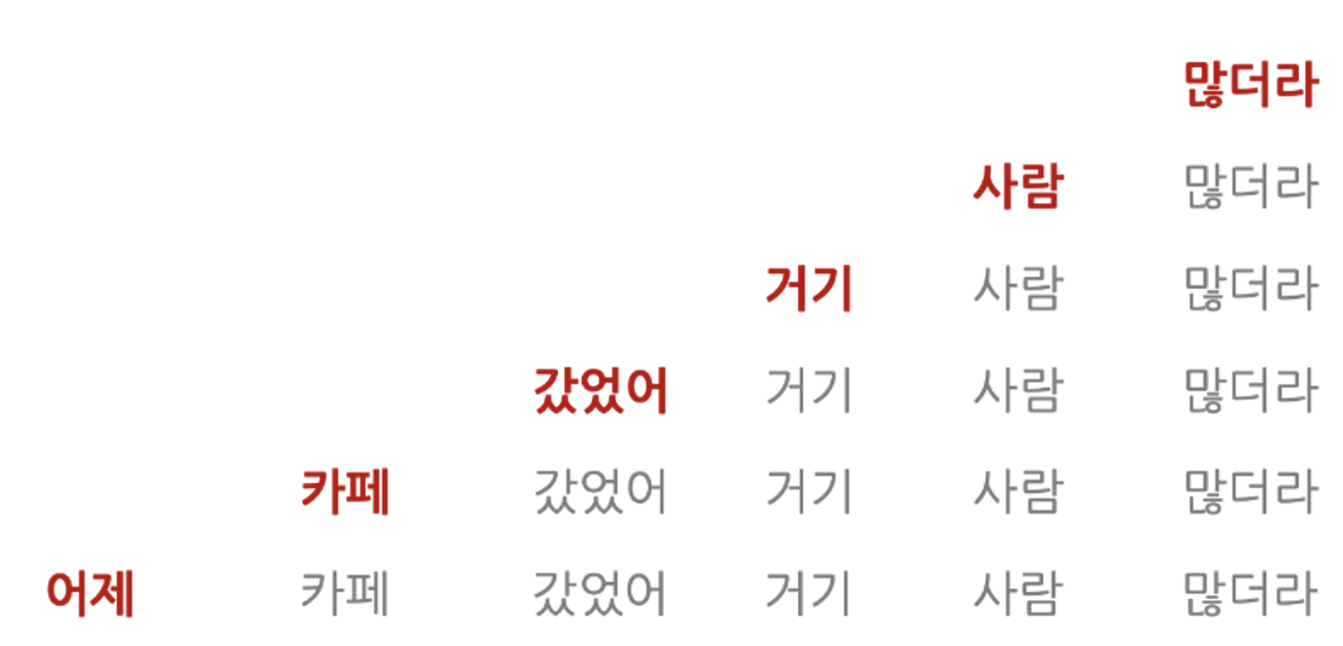

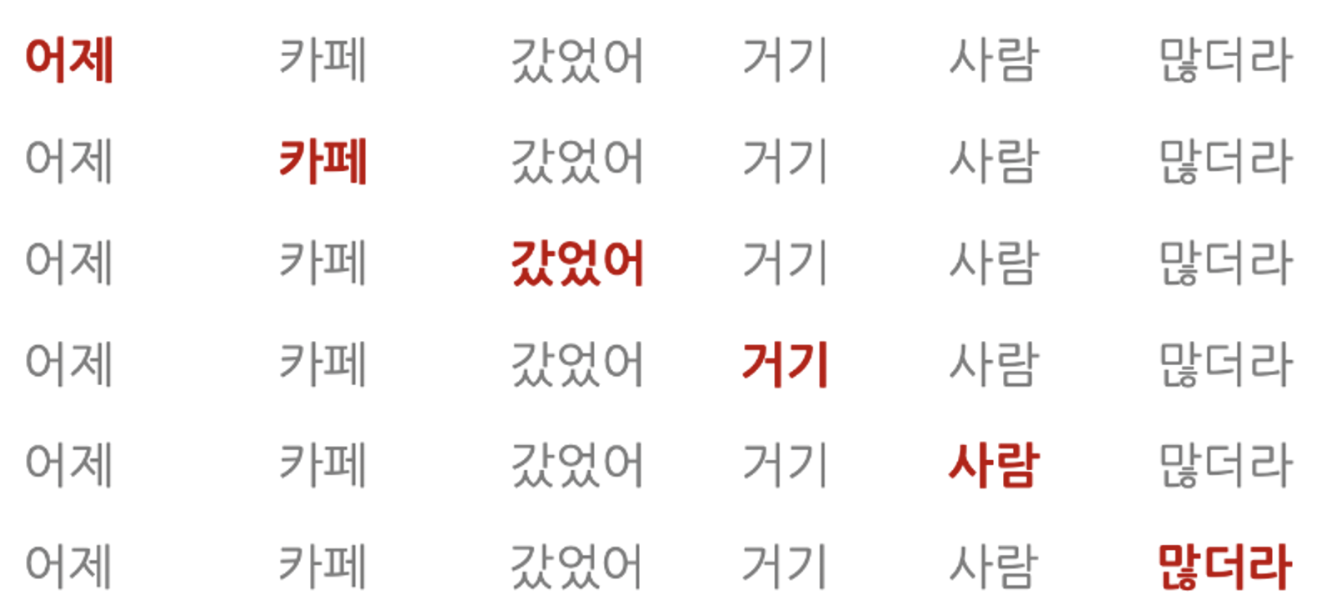

💡 Example: 어제 카페 갔었어 거기 사람 많더라

- 회색 단어는 컨텍스트, 붉은색 단어는 맞혀야할 다음 단어를 의미

- 이처럼 문장 앞부터 뒤로, 사람이 이해하는 순서대로 계산하는 모델을 순방향(forward) 언어모델 → GPT, ELMo가 대표적이다.

역방향 언어모델

- 역방향 언어모델은 방향만 봐뀜, 다음 단어 맞추기 과정에서 전체 단어 시퀀스가 나타날 확률을 계산할 수 있습니다.

- ELMo 같은 모델이 이같은 방식으로 프리트레인을 수행

💡 ELMo(Embeddings from Language Models)→ 순방향과 역방향 언어 모델 모두 활용하는 기법

넓은 의미의 언어모델

최근에는 언어모델은 이런 수식으로 정의 하기도 한다. → P(w | context)

- context → 주변 맥략 정보가 전제된 상태에서 특정 단어(w)가 나타날 조건부 확률을 의미

- 이렇게 정의된 언어모델은 단어 or 단어 시퀀스로 정의된 context를 input → 특정 단어 나타날 확률 출력

Mask 언어모델

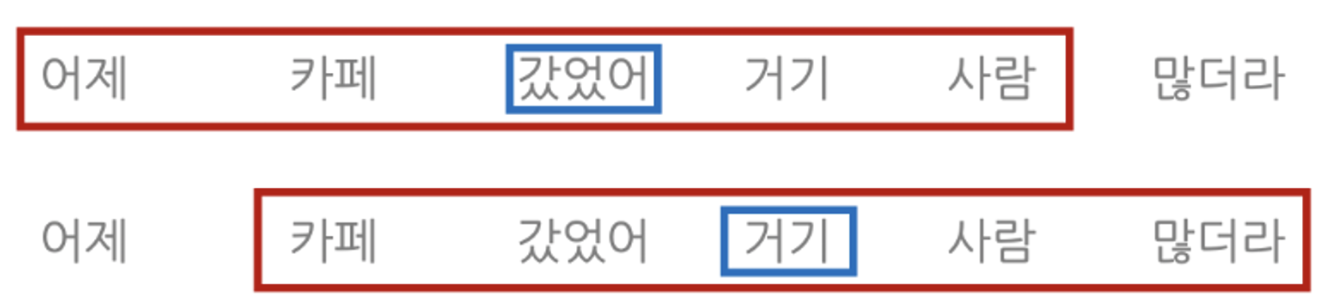

💡 학습 문장에 빈칸을 만들어 놓고, 해당 빈칸에 올 단어로 적절한 단어가 무엇인지 분류하는 과정으로 학습 → 대표적으로 BERT

- 회색은 context → [MASK] 카페 갔었어 거기 사람 많더라

- 빨간색이 Target → 맞힐 대상

💡 맞힐 단어 이전 단어들만 참고할 수 있는 순방향/역방향 언어모델과 달리 마스크 언어 모델은 맞힐 단어를 계산할 때 문장 전체의 맥락을 참고할 수 있음

- 마스크 언어모델에 양방향(bidirectional) 성질 = 맞힐 단어 앞뒤를 모두 본다는 뜻

Skip-Gram 모델

💡 어떤 단어 앞뒤에 특정 범위를 정해 두고 이 범위 내에 어떤 단어들이 올지 분류하는 과정에서 학습

- Skip-Gram Model은 갔었어 주변에 어제, 카페, 거기, 사람이 나타날 확률을 각각 높이는 방식으로 학습

- 거기 주변에 카페, 갔었어, 사람, 많더라가 나타날 확률을 각각 높임.

- 즉 스킵-그램 모델은 context로 설정한 단어 주변에 어떤 단어들이 분포해 있는지를 학습 하는 방식

Word2Vec이 skip-gram 모델 방식

반응형

'📝 NLP (자연어처리) > 📕 Natural Language Processing' 카테고리의 다른 글

| [NLP] RNN (Recurrent Netural Network) - 순환신경망 (0) | 2024.01.22 |

|---|---|

| [NLP] Seq2Seq, Encoder & Decoder (0) | 2024.01.19 |

| [NLP} Tokenization - 토큰화하기 (0) | 2024.01.18 |

| [NLP] Building a vocabulary set - 어휘 집합 구축하기 (0) | 2024.01.18 |

| [NLP] Tokenization - 토큰화란? (0) | 2024.01.16 |