전에 썼던 내용에 이어서 써보겠습니다.

합성곱 신경망 (CNN Model)과 비교한 Self-Attention

CNN은 *Convolution filter(합성곱 필터)라는 특수한 장치를 이용해서 Sequence의 지역적인 특징을 잡아내는 모델입니다.

- 여기서 Convolution filter(합성곱 필터)는 합성곱 신경망을 구성하는 하나의 요소-필터는 데이터를 전체적으로 훑으면서 인접한 정보를 추출하는 역할을 합니다.

- 자연어는 기본적으로 Sequence(단어 혹은 형태소의 나열)이고 특정 단어 기준 주변 문맥이 의미 형성에 중요한 역할을 하고 있으므로, CNN이 자연어 처리에 널리 쓰이고 있습니다.

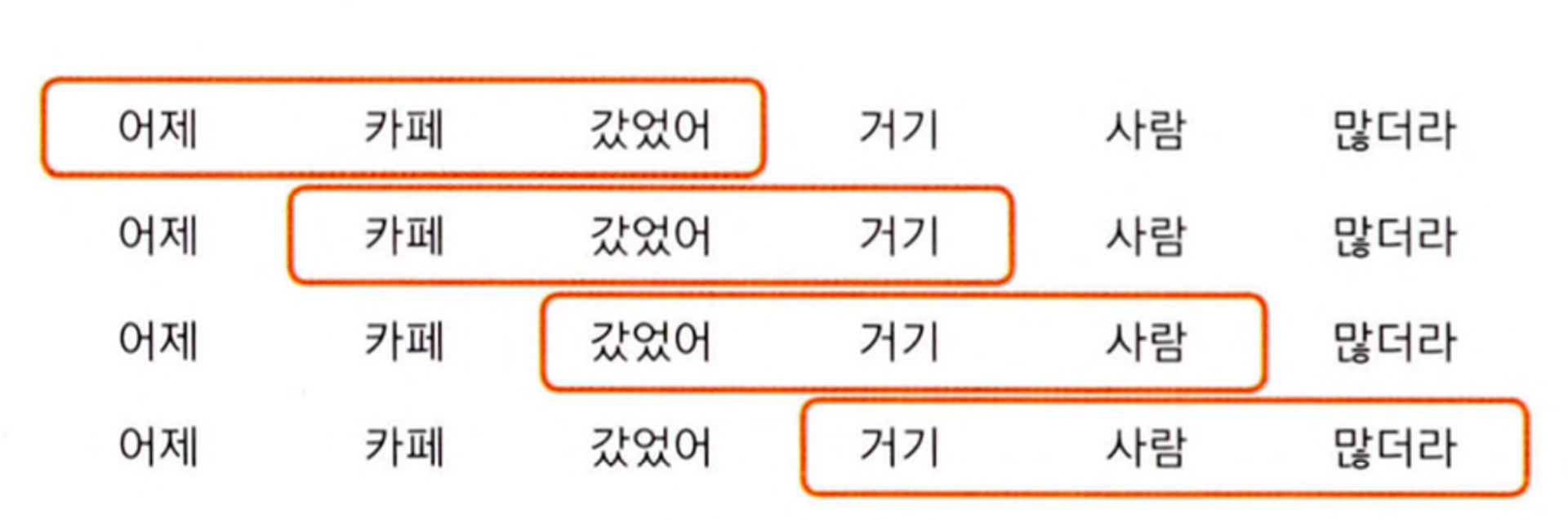

- 위의 그림은 CNN 문장의 Encoding 방식입니다. Convolution filter(합성곱 필터)가 단어를 하나씩 너기면서 차례대로 읽어 들이는걸 알 수 있습니다.

- 그런데, CNN은 합성곱 필터 크기를 넘어가는 문맥은 읽어내기 어렵다는 단점이 있습니다. 예를 들어서 필터의 크기가 3이면 4칸 이상 떨어저 있는 단어 사이의 의미는 캐치하기 어렵습니다.

순환신경망 (RNN)과 비교한 Self-Attention

순환신경망 (RNN)은 Sequence(시퀀스)정보를 압축하는데 강점이 있는 구조입니다.

- 예를 들어서 Source 언어 Sequence인 '어제, 카페, 갔었어, 거기, 사람, 많더라' 를 Encoding해야 한다면 가정해면?

- RNN은 순서대로 Source Sequence를 차례대로 처리합니다.

- 그러나 RNN은 Sequence의 길이가 길어질수록 정보를 압축하는데 문제가 발생합니다.

- 이유는 RNN의 특성때문입니다. RNN은 입력 정보를 차례대로 처리하고 오래전에 읽었던 단어는 잊어버리는 경향이 있기 때문입니다.

- 정리하면, RNN은 오래전에 입력된 단어는 잊어버리거나, 특정 단어 정보를 과도하게 반영해 전체 정보를 왜곡하는 경우가 자주 생깁니다.

Encoder에서 수행하는 Self-Attention

- Encoder Block의 입력은 이전 블록의 단어 Vector Sequence, 출력은 이번 블록 수행 결과로 도출된 단어 Vector Sequence 입니다.

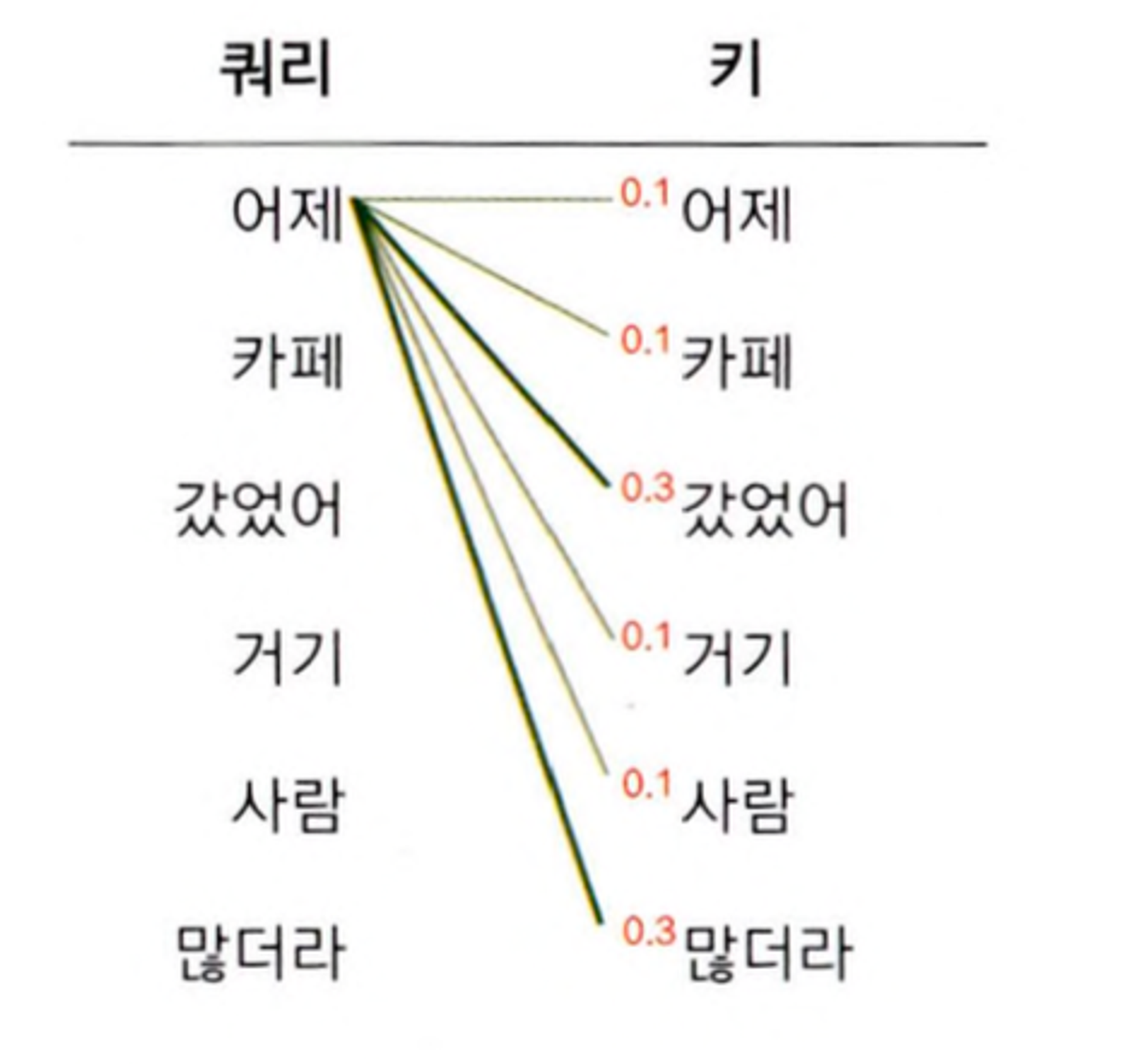

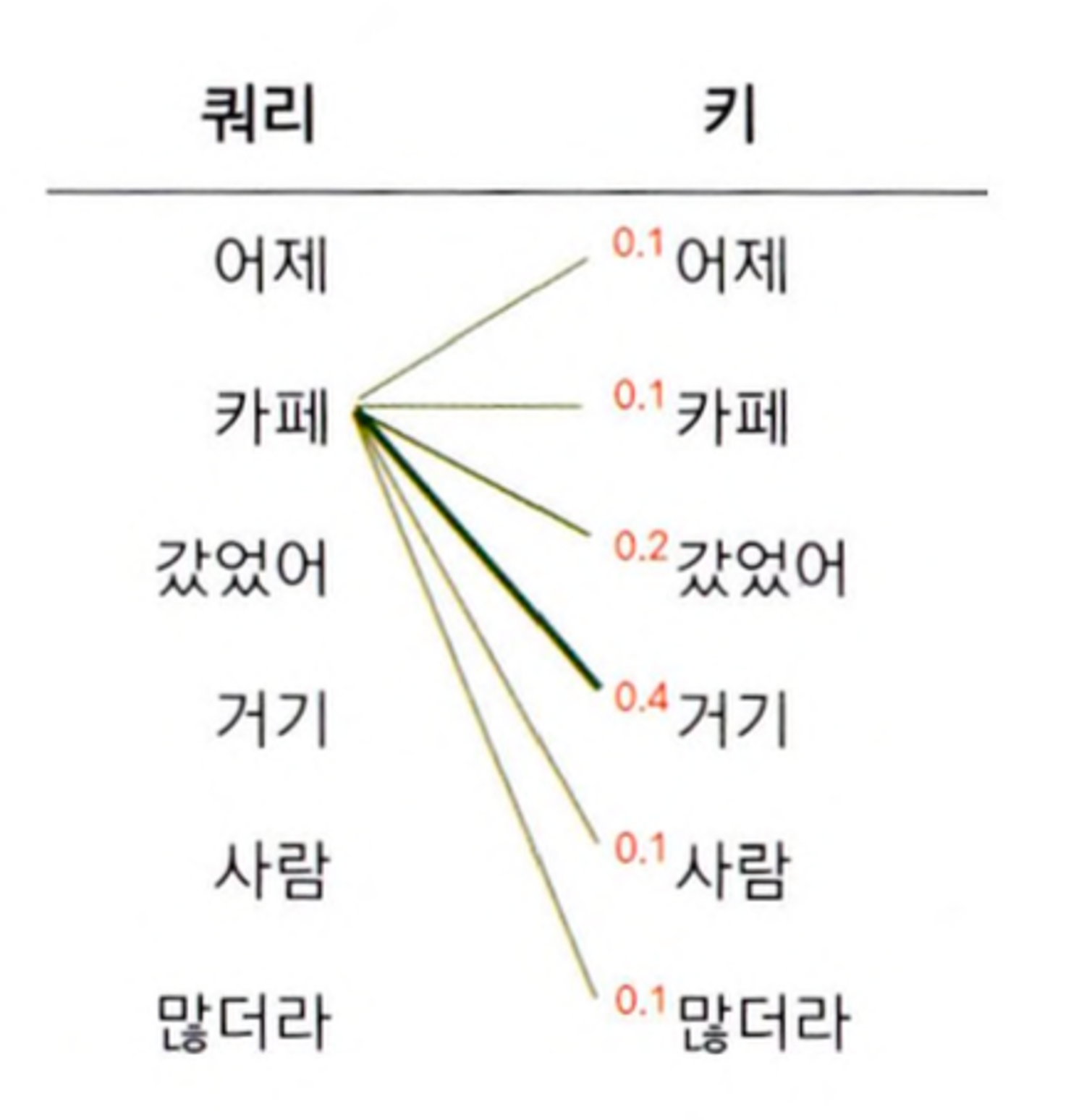

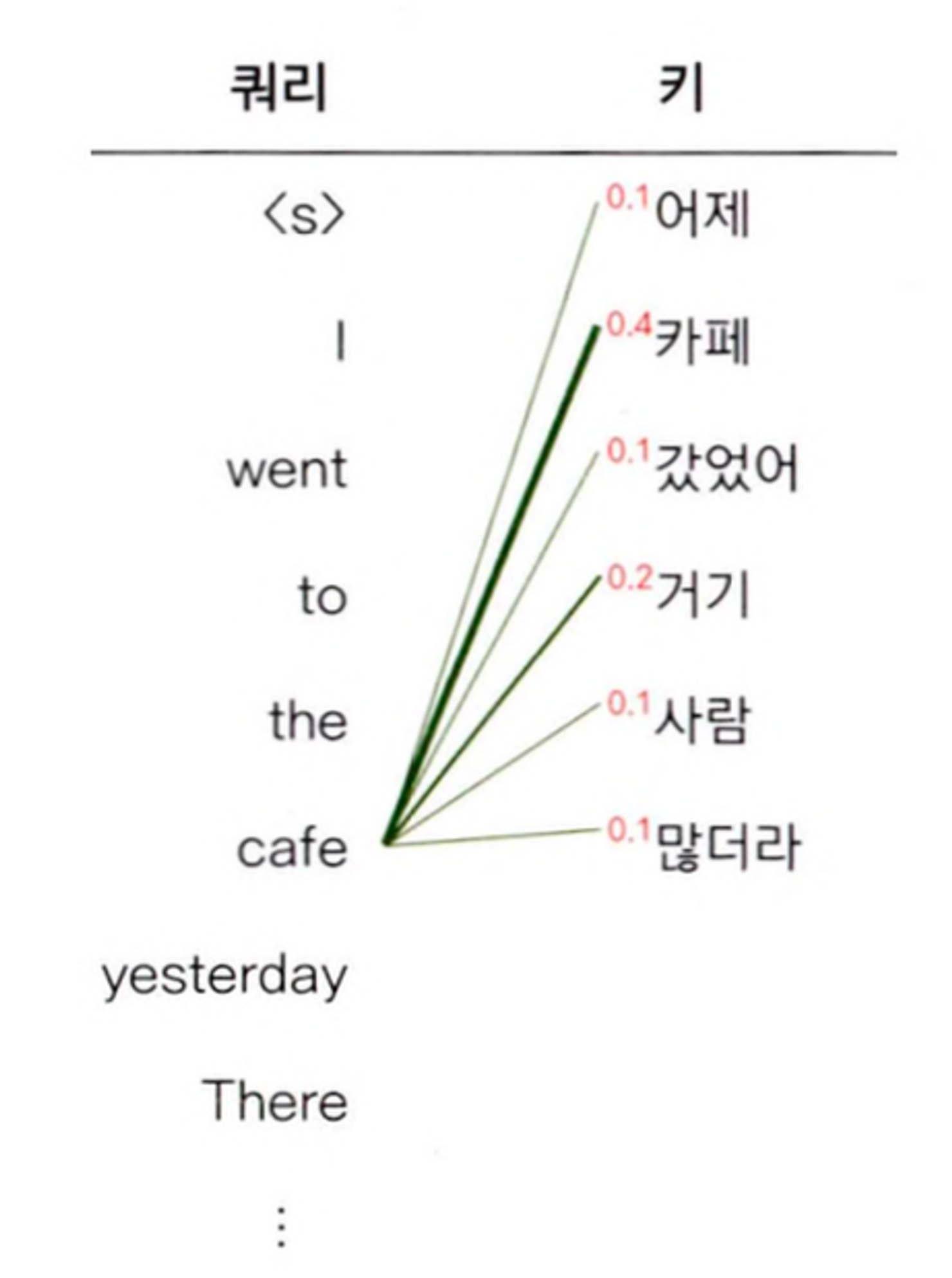

- 예를 들어서 쿼리가 '어제' 인경우, '카페' 인경우의 Softmax 확률값 들을 그림으로 나타내었습니다.

Decoder에서 수행하는 Self-Attention

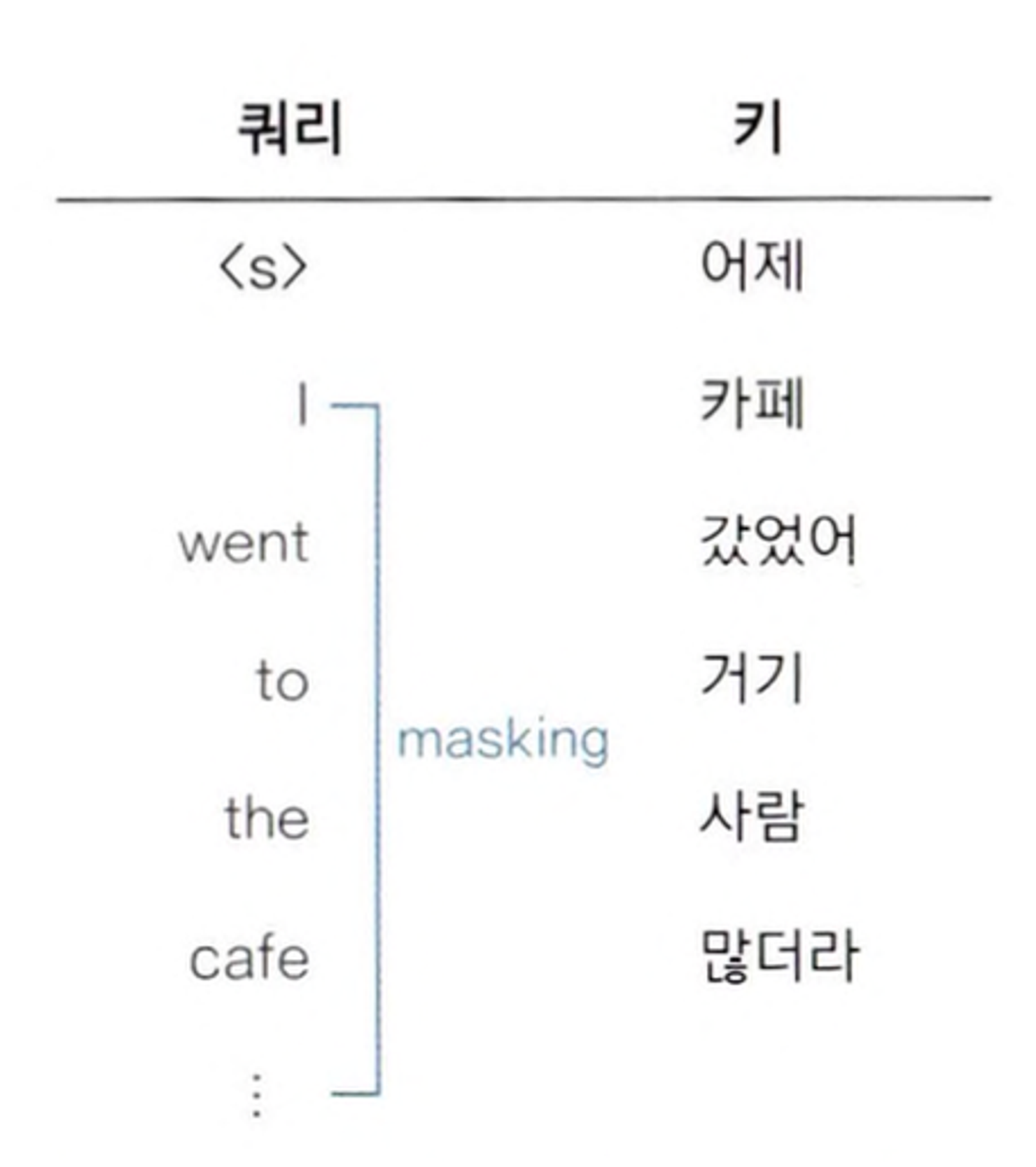

- Decoder에서의 Self-Attention에 데하여 알아보기 전에 Mask Multi-Head Attention에 데하여 알아보겠습니다.

- Mask Multi-Head Attention은 Transformer 모델의 Decoder 부분에서 사용되며, Sequence를 생성할 때, 각 시점에서만 과거의 정보를 볼 수 있도록 합니다.

- 이는 미래의 정보를 참조 하지 않도록 합니다. 한번 예를 들어서 설명해 보겠습니다.

- 위의 왼쪽 그림은 Target 언어의 단어 Vector Sequence를 계산한 대상입니다.

- 근데 여기서는 Input Sequence가 영어로 봐뀌었을뿐, Decoder쪽 Self-Attention과 크게 다른점은 없습니다.

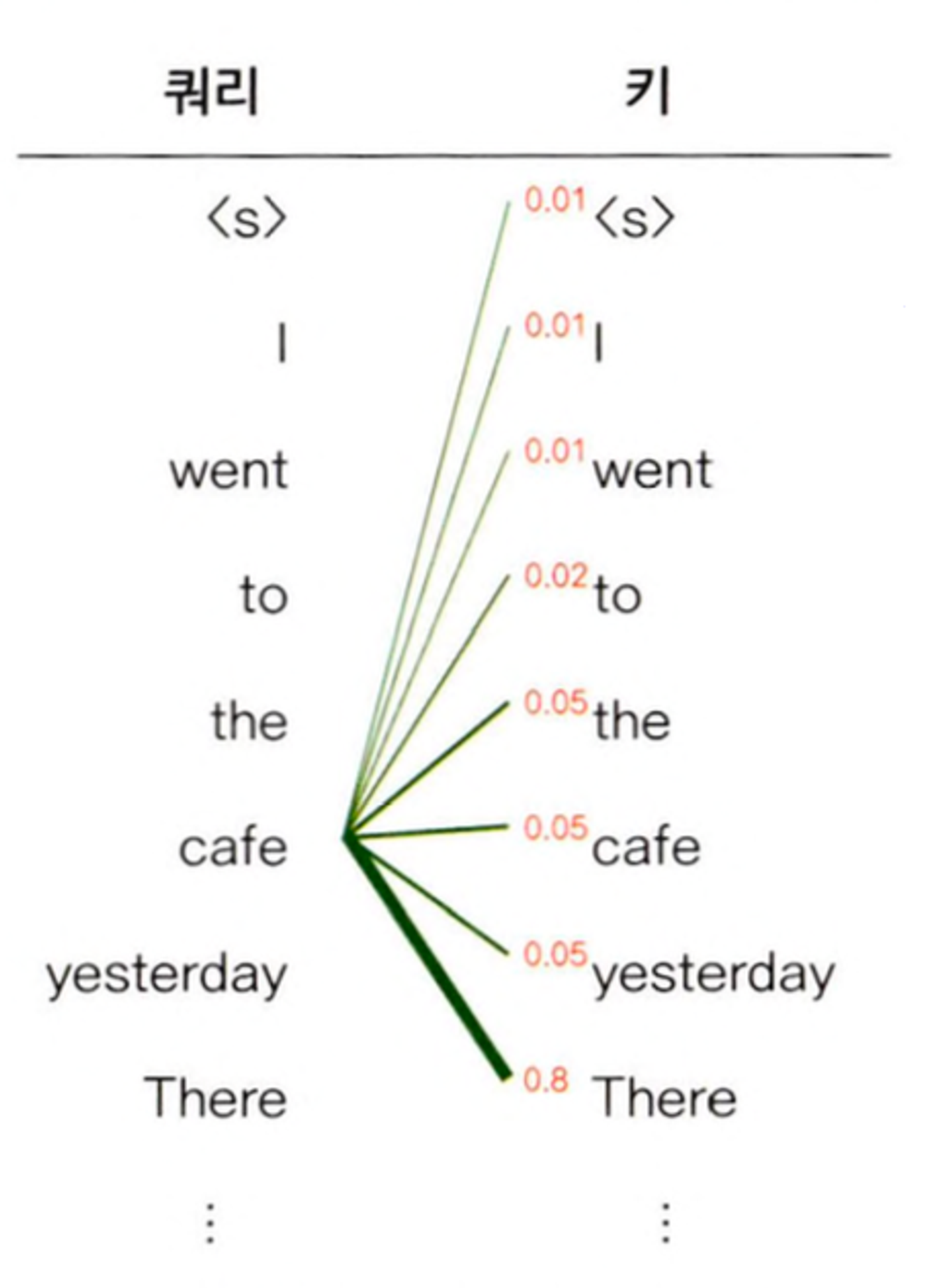

- 위의 오른쪽 그림은 Query(쿼리)가 cafe인 경우 Mask Multi-Head Attention을 나타낸것입니다.

- 그림을 보면 여기서의 Multi-Head Attention은 Encoder, Decoder 정보를 모두 활용합니다.

- Encoder에서의 넘어온 정보는 Source 언어의 문장("어제 카페 갔었어 거기 사람 많더라")의 단어 Vector Sequence 입니다.

- Decoder의 정보는 Target 언어의 문장 ("<s> I went to the cafe yesterday There ...")의 단어 Vector Sequence 입니다.

- 여기서 전자를 Key(Encoder 정보), 후자를 Query(Decoder 정보)로 삼아서 Self-Attention 계산을 수행합니다.

- 위의 오른쪽 그림은 쿼리 단어가 cafe인 Multi-Head Attention 계산을 나타낸 것입니다.

- 만약 학습이 잘 되었다면, 쿼리(타깃 언어 문장), 키(소스 언어 문장)로부터 계산한 소프트맥스 확률 가운데, 쿼리에 대응하는 해당 장소를 지칭하는 단어가 높은 값을 지닐것입니다.

- Softmax 확률값들과 Value 벡터를 가중합해서 셀프 어텐션 계산을 마칩니다.

여기서 보면 학습(Training)과정에서 약간의 Trick을 썼습니다.

다음글에서 자세히 트랜스포머 모델에 데하여 글을 쓰겠지만,

트랜스포머 모델의 최종 출력은 타겟 시퀀스 각각에 대한 확률 분포, 문장의 다음 단어가 어떤 것이 적절할지에 관한 확률을 나타냅니다.

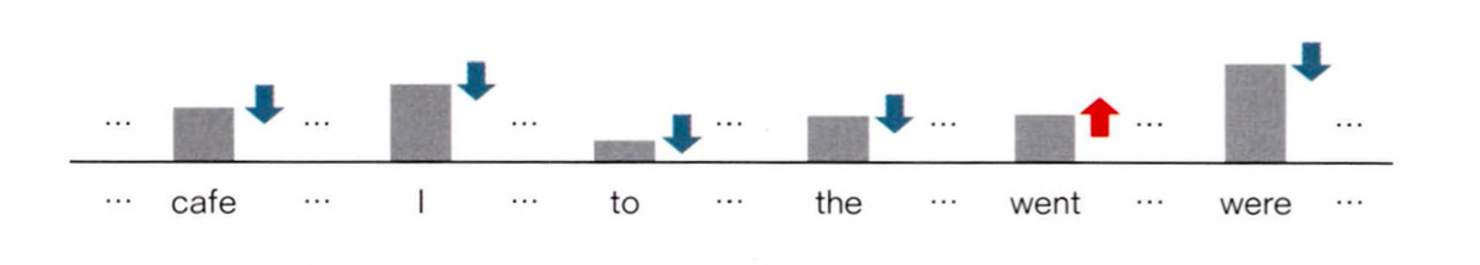

- 인코더에 어제 카페 갔었어 거기 사람 많더라가, 디코더에 <s>가 입력된 상황이면, 트랜스포머 모델은 다음 영어 단어 I를 맞추도록 학습합니다. → 근데 모델이 맞춰야 하는 정답인 I를 알려주면 학습 하는 의미가 없습니다.

- 그래서, 정답을 포함한 미래 정보를 셀프 어텐션 계산에서 제외합니다. → 그래서 디코더 블록의 첫번째 Attention을 마스크 멀티-헤드 어텐션(Masked Multi-Head Attention)이라고 부릅니다.

- Masking은 확률이 0이 되도록 하여, 밸류와의 가중합에서 해당 단어 정보들이 무시되게끔 하는 방식으로 수행됩니다.

- 디코더 마지막 블록의 I 벡터에는 소스 문장(어제 … 갔더라)과 <s> I 사이의 문맥적 관계성이 녹아 있습니다.

- 트랜스포머 모델은 이 I 벡터를 가지고 went를 맞히도록 학습됩니다. → 정답 went에 관한 확률은 높이고 다른 단어들의 확률은 낮아지도록 합니다.

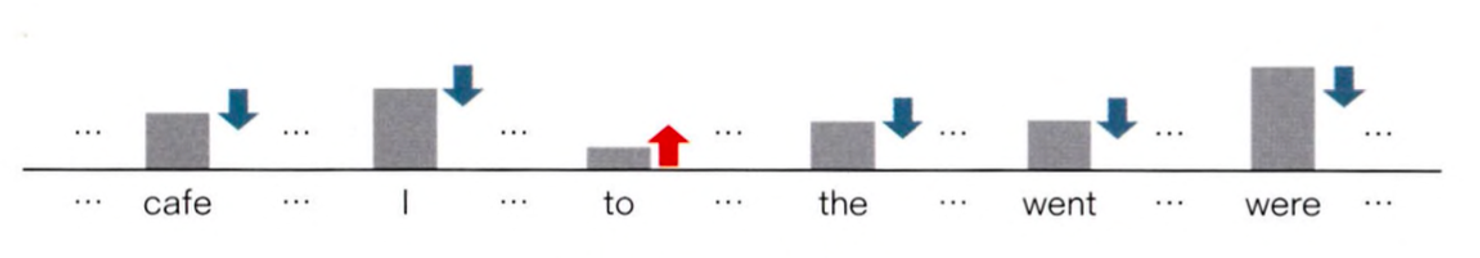

- 아래 그림을 보면, Encoder에 어제 카페 갔었어 거기 사람 많더라가, 디코더에 <s> I went가 입력된 상황입니다.

- 따라서 이때의 Masked Multi-Head Attention 은 정답 단어 to 이후의 모든 타깃 언어 단어들을 모델이 보지 못하도록 하는 방식으로 수행합니다.

- 디코더 마지막 블록의 went 벡터에는 소스 문장과 <s> I went 사이의 문맥적 관계성이 녹아있습니다.

- 트랜스포머 모델은 이 went에 해당하는 벡터를 가지고 to를 맞추도록 학습 → 다시 말해 정답 to에 관한 확률은 높이고 다른 단어들의 확률은 낮아지도록 합니다.

학습이 마친 모델이 수행하는 과정

- 소스 언어(한국어) 문장을 인코더에 입력해 인코더 마지막 블록의 단어 벡터 시퀀스를 추출합니다.

- 인코더에서 넘어온 소스 언어 문장 정보와 디코더에 타깃 문장 시작을 알리는 스페셜 토큰 <s>를 넣어서, 타깃 언어(영어)의 첫 번째 토큰을 생성합니다.

- 인코더 쪽에서 넘어온 소스 언어 문장 정보와 이전에 생성된 타깃 언어 토큰 시퀀스를 디코더에 넣어서 만든 정보로 타깃 언어의 다음 토큰을 생성합니다.

- 생성된 문장 길이가 충분하거나 문장 끝을 알리는 스페셜 토큰 </s>가 나올 때까지 3을 반복합니다.

- 한편 </s>는 보통 타깃 언어 문장 맨 마지막에 붙여서 학습. 이 토큰이 나타났다는 것은 모델이 타깃 문장 생성을 마쳤다는 의미입니다.

다음글은 Transformer 모델에 관한 글을 들고 오겠습니다^^

'📝 NLP (자연어처리) > 📕 Natural Language Processing' 카테고리의 다른 글

| [NLP] Thesaurus(시소러스), Co-occurence Matrix(동시발생 행렬) (0) | 2024.05.18 |

|---|---|

| [NLP] Transformer Model - 트랜스포머 모델 알아보기 (0) | 2024.03.07 |

| [NLP] Attention - 어텐션 (0) | 2024.02.17 |

| [NLP] Word Embedding - 워드 임베딩 (0) | 2024.02.12 |

| [NLP] Word2Vec, CBOW, Skip-Gram - 개념 & Model (0) | 2024.02.03 |