Activation Function (활성화 함수)

Activation Function(활성화 함수)란?

신경망에서 각 Node & Neuron에서 Input Signal(입력신호)의 총합을 Output Signal(출력 신호)로 변환하는 함수입니다.

- 또한 Nerual Network(신경망)의 Non-Linear 문제를 해결하게 해줍니다.

비선형 문제: 입력, 출력 변수간의 관계가 선형이 아닌 문제를 의미합니다. 입력 변수가 작은 변화가 출력에 비례하지 않거나, 예측하기 어려운 변화를 일으키는 경우에 해당

- Activation Function(활성화 함수)는 임계값을 기준으로 출력이 봐뀝니다, 이런 함수를 Step Function(계산 함수)라고 합니다.

- 그래서 Perceptron(퍼셉트론)에서 Activation Function(활성화 함수)로 Step Function(계산 함수)을 이용한다고 합니다.

- 즉, Activation Function(활성화 함수)으로 쓸수 있는 여러함수중 Step Function(계산 함수)를 사용한다고 하는데, 그러면 Step Function(계산 함수)의외의 다른 함수를 사용하면 어떻게 될까요? 한번 알아보겠습니다

Activation Function (활성화 함수) 종류

- Sigmoid, Tanh, ReLU, Maxout, Leaky ReLU, ELU등 6개의 활성화 함수에 데하여 알아보겠습니다.

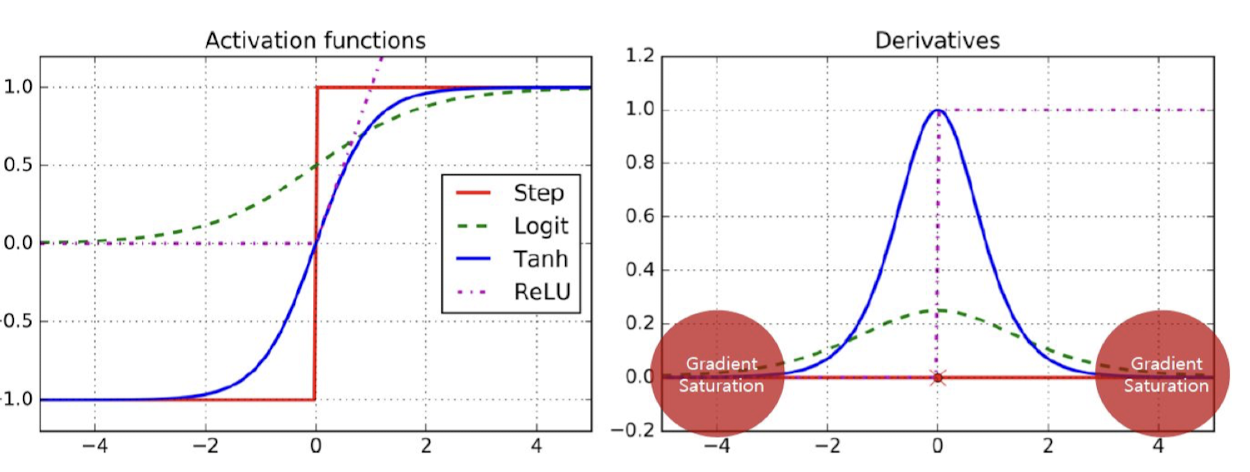

Step Function (계단 함수)

- 생체 뉴런의 발화 방식과 유사, Perceptron에서 사용, 값이 0 & 1 둘중에 하나만 출력됩니다.

- 입력이 0을 넘으면 1을 출력하고, 그 외에는 0을 출력하는 함수합니다.

- Step Function(계단 함수)는 미분값이 0이여서 학습이 불가능 합니다.

- 그래서 Gradient(기울기) 방식의 최적화를 사용하는 Neural Network(신경망) 에서는 사용할수 없습니다. 이유는 무엇일까요?

1. Step Function 에서는 임계값이 불연속적으로 변하는데, 그 지점에서는 미분이 불가능합니다.

신경망 학습에서는 Weight를 조정하기 위해서 Loss Function의 Gradient가 필요한데, Step 함수는 미분값을 제공 할수 없습니다.

2. Gradient Loss 문제, Step 함수에서는 대부분의 Gradient는 0이므로, Weight(가중치) 업데이트가 제대로 이루어 지지 않으므로, 신경망이 학습을 할수 없습니다.

Sigmoid Function - 시그모이드 함수

- Step Function (계산 함수)의 부드러운 버전 (그래프)입니다.

- 계단 함수와 달리 미분이 가능합니다.

- exp(지수함수) 계산 비용이 비쌉니다.

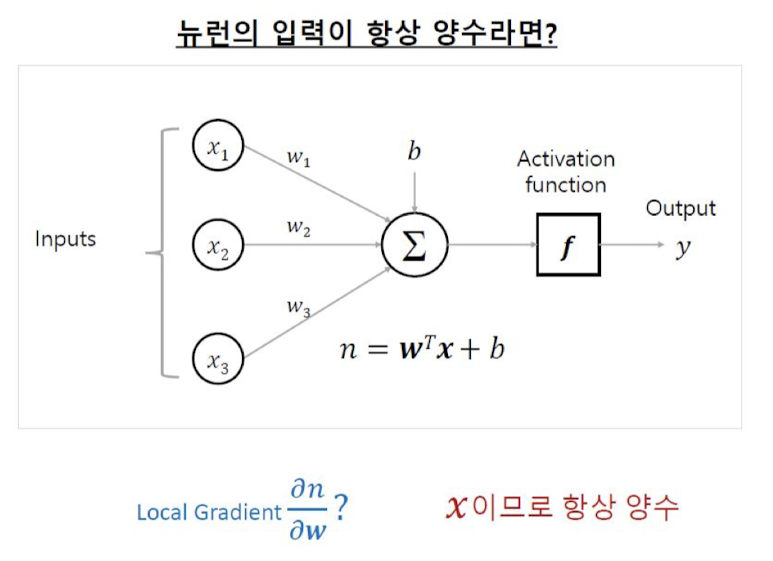

- Zero-centered가 아니여서 최적화에 비효율적입니다. 이유는 무엇일까요?

1. Sigmoid 함수의 정의에 따라 exp(지수함수) 계산 비용은, 신경망이 깊어지고, 네트워크의 크기가 커지면 계산 비용이 증가할수도 있습니다.

2. Sigmoid 함수는 그래프를 보면 입력이 크면 무한대로 다가가는데, 이건 Gradient Loss 문제가 발행할수도 있습니다. 또한 입력값이 모두 양수, 음수인 경우 Gradient가 0에 가까워질 수 있습니다. 이건 Gradient Vanishing (기울기 소실)문제가 발생할 수 있습니다.

Zero-Centered Function

함수의 출력이 중심이 0인 함수를 의미합니다. 이것은 활성화 함수의 출력이 양수와 음수 모두를 포함하고 있음을 의미합니다.

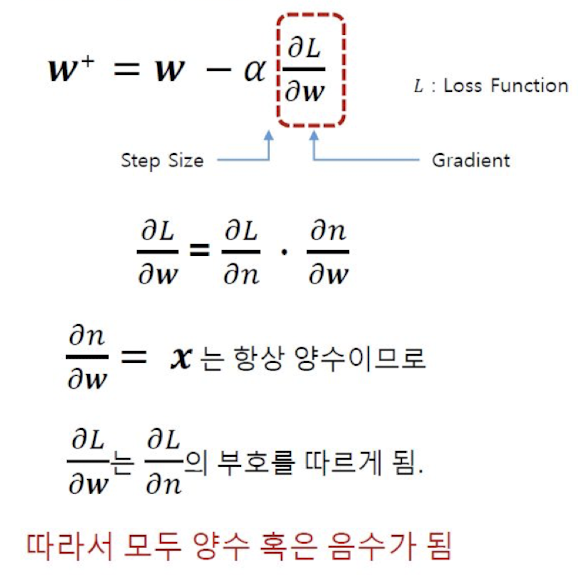

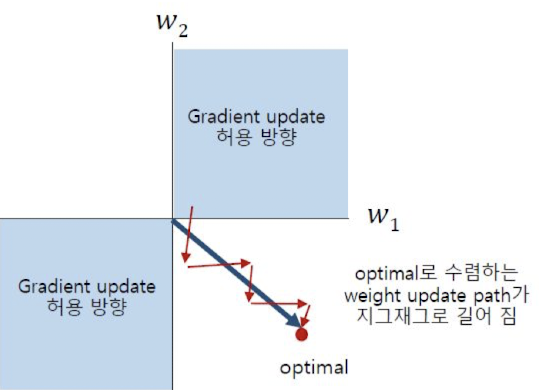

- zero-centered 함수를 사용할 때, 기울기(gradient)의 부호가 양수와 음수 모두를 가질 수 있습니다.

- 즉, 요약하면 경사 하강법은 기울기(gradient)의 부호를 따라 매개변수를 업데이트 하는 방식으로 진행됩니다.

- 또한 최적화 함수가 지그재그로 길어집니다.

- Gradient Update가 허용하는 방향에서 optimal로 수렴하는 weight update path가 지그재그로 길어진다는 현상이 있습니다.

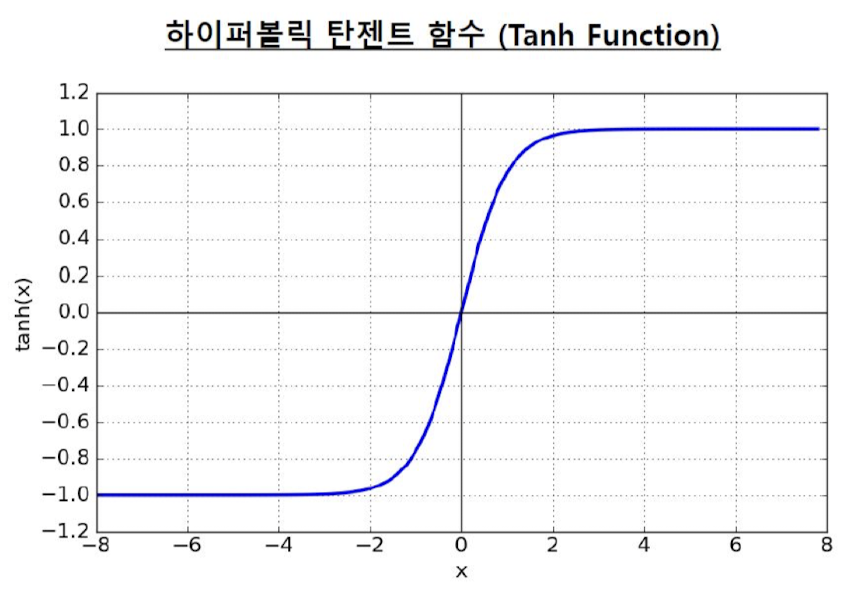

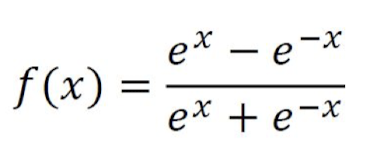

Hyperbolic Tangent Function (Tanh)

하이퍼볼릭 탄젠트 함수(tanh)는 수학적으로 시그모이드 함수와 비슷한 형태를 가지고 있지만, -1과 1 사이의 범위를 갖습니다. 하이퍼볼릭 탄젠트 함수는 아래와 같이 정의됩니다:

- 이 함수는 입력 x를 받아 -1에서 1 사이의 값을 출력합니다. 이 함수는 대부분의 시그모이드 함수와 마찬가지로 S 모양의 곡선을 그리며, 0 주변에서 대칭적인 형태를 보입니다.

- 하이퍼볼릭 탄젠트 함수는 주로 신경망에서 사용되는 활성화 함수 중 하나입니다. 시그모이드 함수와 마찬가지로 비선형성을 가지고 있어 신경망이 복잡한 패턴을 학습할 수 있도록 돕습니다.

- 하지만 하이퍼볼릭 탄젠트 함수는 시그모이드 함수와는 달리 출력 범위가 -1부터 1까지로 확장되어, 입력이 0 주변에서 더 빠르게 변화합니다. 이러한 특성은 그래디언트 소실 문제를 완화하는 데 도움이 될 수 있습니다.

- 또한 하이퍼볼릭 탄젠트 함수는 입력이 큰 경우에는 -1 또는 1로 수렴하므로, 출력을 제한하는 데에도 사용될 수 있습니다.

- 또한 Zero-Centered 함수이며, exp(지수 계산)비용이 비쌉니다.

Tanh 함수의 미분

- 하이퍼볼릭 탄젠트 함수를 미분할때 Gradient Saturation 문제가 발생합니다.

- 여기서 Gradient Saturation 문제는 Gradient(기울기)가 너무 적아지거나 너무 커지는 현상입니다. Gradient Vanishing or Gradient Explosion

- Gradient Vanishing: Gradient가 너무 작아지는 문제입니다. 신경망이 깊어질수록, 역전파 과정에서 Gradient가 입력층으로 전파되면서 감소할 수 있습니다. → 하위층의 Weight가 업데이트되지 않아 학습에 문제가 됩니다.

- Gradient Explosion: Gradient가 너무 커지는 문제입니다. 시간에 따라 Gradient가 커지면 Weight(가중치)가 너무 크게 업데이트 외서 학습이 불안정 해집니다.

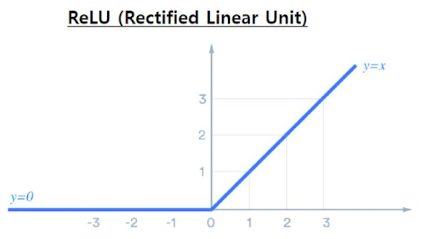

Rectified Linear Unit Function - ReLU 함수

Rectified Linear Unit, ReLU은 신경망에서 가장 널리 사용되는 활성화 함수 중 하나입니다. ReLU 함수는 입력이 0보다 큰 경우에는 입력 값을 그대로 출력하고, 0보다 작은 경우에는 0을 출력합니다.

- 2012년 AlexNet에서 처음 사용하였고, 생체 Neuron의 발화 방식이 Sigmoid보다 더 유사합니다.

- Linear Unit과 비슷하기 때문에 최적화가 매우 잘됩니다.

- Sigmoid, Tanh 보다 6배 정도 학습이 뻐릅니다.

- Active 상태에서 Gradient가 크기 때문에 Gradient Vanishing 문제가 생기지 않습니다.

Active 상태에서의 Gradient: ReLU 함수를 사용할 때, 입력 값이 양수인 경우(Active 상태) 그래디언트(미분값)은 1입니다

이는 역전파 과정에서 그래디언트가 소실되거나(exploding) 사라지는(vanishing) 문제를 크게 완화시킵니다.

단, Dead ReLU과 Not zero-centered 문제가 있습니다.

- Dead ReLU 문제: 입력 값이 음수인 경우, ReLU 함수의 출력은 항상 0입니다.

- 이 경우, 해당 뉴런은 그래디언트 역전파 과정에서 아무런 역할을 하지 못하게 되어, '죽은' 상태(Dead state)로 전환될 수 있습니다.

- 일단 뉴런이 이 상태에 이르면, 그 뉴런은 다시 활성화되기 어렵게 됩니다.

- Not zero-centered 문제: ReLU 함수의 출력은 항상 0 또는 양수입니다.

- 이는 출력 값이 zero-centered 되지 않는다는 것을 의미합니다.

- 데이터가 zero-centered 되지 않으면, 가중치의 업데이트가 한쪽 방향으로 치우치게 되어 최적화 과정에서 비효율적일 수 있습니다.

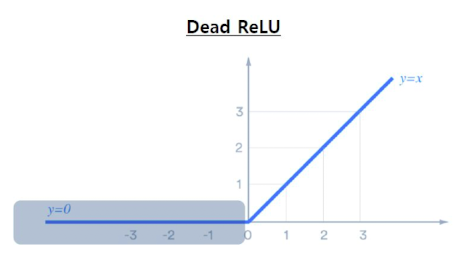

Dead ReLU

학습 중에 일부 뉴런이 항상 0을 출력하게 되어 해당 뉴런이 더 이상 학습에 기여하지 않는 상태를 말합니다.

- ReLU 함수는 입력이 0보다 작은 경우에는 항상 0을 출력하기 때문에, 학습 중에 해당 뉴런이 음수 입력을 받게 되면 계속해서 0을 출력하게 됩니다. x < 0 구간에서 Activation이 0이되면 Gradient가 0이 되어 학습이 진행되지 않습니다.

- 이러한 경우, 해당 뉴런의 가중치(weight) 및 편향(bias)이 업데이트되지 않아 학습 과정에서 뉴런이 죽은 상태로 남아있게 됩니다.

- 이러한 현상이 발생하면, 네트워크의 표현력(representational power)이 제한되고 모델의 성능이 저하될 수 있습니다.

- 또한 초기화를 잘못하거나 Learning Rate가 매우 클 때 발생합니다.

- 테스트 데이터의 10% ~ 20%가 Dead ReLU이면 문제가 될 수도 있음.

Dead ReLU의 해결 방법

Dead ReLU 문제를 해결하기 위한 몇 가지 접근 방법이 있습니다.

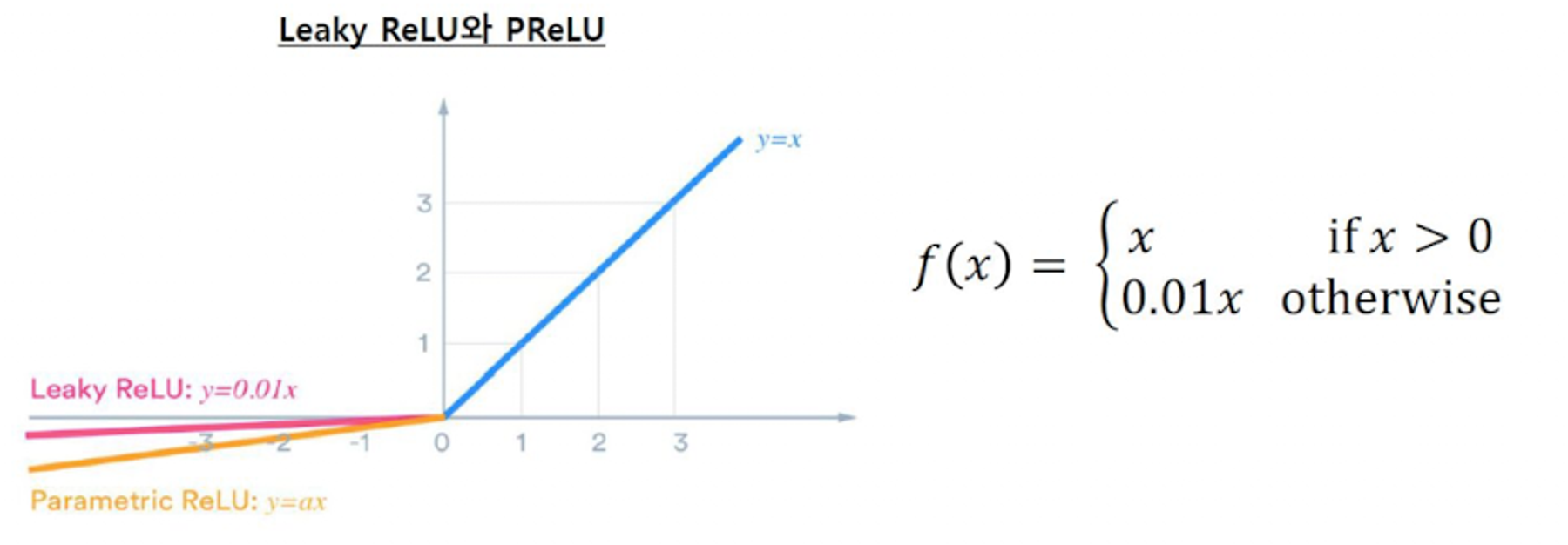

- Leaky ReLU: ReLU의 변형 중 하나로, 음수 입력에 대해 작은 기울기를 가지도록 합니다. 이렇게 하면 음수 입력에 대해 항상 0이 아니라 작은 값을 출력하여 죽은 뉴런 문제를 완화할 수 있습니다.

- Parametric ReLU (PReLU): Leaky ReLU와 유사하지만, 음수 입력에 대한 기울기가 학습 가능한 매개변수로 변합니다. 이를 통해 네트워크가 데이터에 따라 음수 입력에 대해 적합한 기울기를 학습할 수 있습니다.

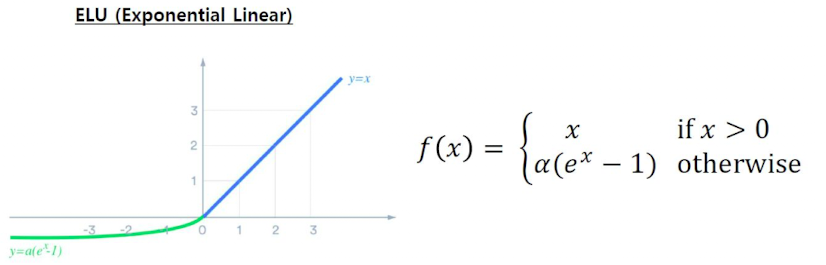

- Exponential Linear Unit (ELU): 음수 입력에 대해 작은 값을 출력하는 대신, ELU는 음수 입력에 대해 지수 함수를 사용하여 부드러운 모양의 곡선을 형성합니다. 이는 Dead ReLU 문제를 완화하고 성능을 향상시킬 수 있습니다.

Leaky ReLU

Leaky ReLU는 입력이 음수인 경우에도 작은 양의 기울기를 가진 선형 함수를 출력합니다.

- Leaky ReLU는 ReLU의 주요 단점중 하나인 Dead ReLU 문제를 해결하기 위해 제안되었습니다.

- 입력값이 음수일때도 Gradient가 완전이 0이 되지 않도록 작은 기울기를 제공합니다.

- 또한 음수 구간에 Gradient가 생김으로써 훈련 속도가 빨라집니다.

- 0.01과 같은 작은 값으로 설정되면 입력이 음수인 경우에도 0보다 큰 기울기를 가지므로, 죽은 ReLU 문제를 완화할 수 있습니다.

ELU (Exponential Linear)

ELU는 음수 입력에 대한 부드러운 모양의 곡선을 형성하는 활성화 함수입니다.

또한 음수 입력에 대해 지수 함수를 사용하여 선형적으로 수렴하는 부분이 있어, ReLU의 단점인 "죽은 뉴런" 문제를 완화하고 신경망의 성능을 향상시킬 수 있습니다.

- ELU는 ReLU의 장점을 유지하면서 그 단점을 개선하고자 하는 목적으로 제안되었습니다.

- 특히, ReLU에서 발생할 수 있는 Dead ReLU 문제와 출력이 zero-centered 되지 않는 문제를 해결하고자 합니다.

- 여기서 α는 음수 입력에 대한 ELU 함수의 특정 영역에서의 부드러운 선형 부분을 결정하는 양수 하이퍼파라미터입니다. 일반적으로

- α는 1보다 크거나 같은 값으로 설정됩니다.

- ELU 함수는 음수 입력에 대해 ReLU보다 부드럽고 더 빠르게 수렴하는 형태를 가지며, 이는 학습 속도를 향상시키고 더 강력한 표현력을 제공할 수 있습니다. 또한, ELU 함수는 음수 입력에 대해 작은 기울기를 가지므로 그래디언트 소실 문제를 완화할 수 있습니다.

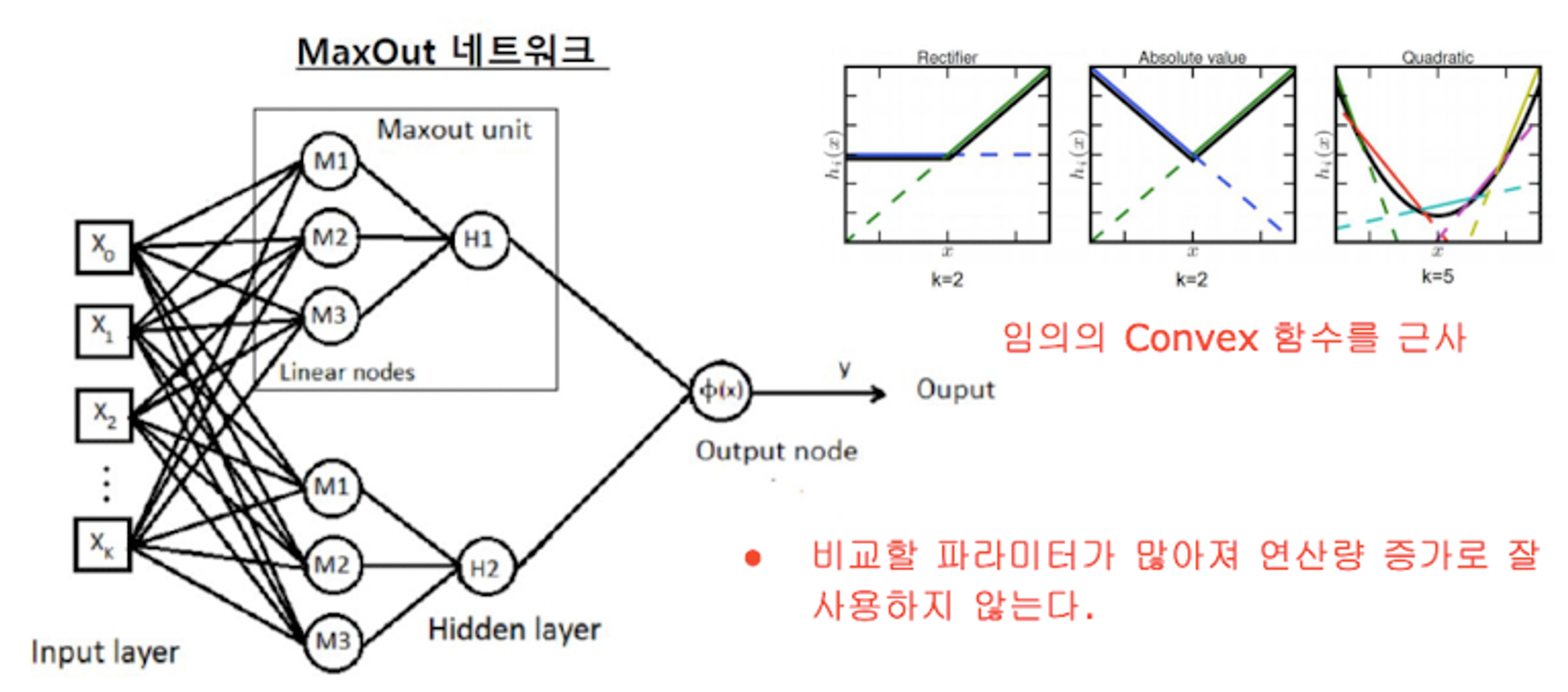

MaxOut

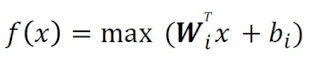

Maxout은 다양한 형태의 활성화 함수를 학습 가능한 파라미터로 사용하는 아키텍처입니다.

주로 딥 러닝에서 사용되며, 특히 이미지 인식과 관련된 문제에서 유용하게 적용될 수 있습니다

여러 개의 선형 함수의 출력 중 최댓값을 선택하여 그것을 다음 레이어로 전달하는 방식입니다.

( x )에 대해 ( k )개의 서로 다른 가중치 벡터와 편향을 적용한 후, 이들 중 최댓값을 선택하여 출력합니다.

- ReLU를 일반화한 Piecewise Linear Function을 학습합니다. 또한 성능이 뛰어납니다.

- 여러 Weight(가중치), Bias(편견)에 대해 값을 구해서 최대 값을 취하는 방식으로 구간 별 최대 Linear Activation을 선택하는 효과가 있습니다.

'🖥️ Deep Learning' 카테고리의 다른 글

| [DL] Batch Normalization - 배치 정규화 (0) | 2024.05.01 |

|---|---|

| [DL] Training Related Skills - SGD, Momentum, AdaGrad, Adam (학습 관련 기술들) (0) | 2024.04.30 |

| [DL] Feed-forward Network (피드-포워드 네트워크) (0) | 2024.04.18 |

| [DL] 단순한 Layer 구현해보기 (0) | 2024.03.31 |

| [DL] Backpropagation (오차역전파법) (0) | 2024.03.27 |