스터디 준비를 하다가 정리한 내용을 한번 Review를 해보겠습니다.

Training language models to follow instructions with human feedback

Abstract

언어 모델의 크기를 키우는 것만으로는 사용자 의도에 더 잘 부합하도록 만드는 것이 아닙니다. 예를 들어, 대규모 언어 모델은 진실하지 않거나, 유해하거나, 사용자에게 도움이 되지 않는 출력을 생성할 수 있습니다. 즉, 이러한 모델은 사용자의 의도에 맞춰져 있지 않습니다. 여기서는 인간의 피드백으로 미세 조정하여 다양한 작업에서 사용자 의도와 일치하는 언어 모델을 개발하는 방법을 제시합니다.

OpenAI API를 통해 수집된 레이블러가 작성한 프롬프트와 데모 데이터를 사용하여 모델이 원하는 동작을 시연하는 데이터셋을 수집하고, 이를 사용해 GPT-3를 지도 학습으로 미세 조정했습니다. 이후 모델 출력의 순위를 매긴 데이터를 수집하고, 이를 바탕으로 인간의 피드백을 활용한 강화 학습을 통해 이 지도 학습 모델을 추가로 미세 조정했습니다.

이로써 생성된 모델을 InstructGPT라고 부릅니다. API 프롬프트 분포에 대한 인간 평가에서, 1.3B 파라미터 InstructGPT 모델의 출력은 175B 파라미터의 GPT-3보다 선호되었습니다. InstructGPT 모델은 진실성과 독성 감소 면에서 향상을 보였으며, 공공 NLP 데이터셋에서의 성능 감소는 최소화되었습니다.

Introduction

대규모 언어 모델(Large Language Models, LMs)이 파라미터 수를 증가시키면서 성능이 향상된다고 밝히고 있습니다(Brown et al., 2020). 하지만, 이 성능 증가는 주로 공공 NLP 데이터셋에서의 객관적 성능에 불과하며, 모델이 실제 인간의 의도를 제대로 반영하지 못하는 문제가 있습니다. 이를 "misalignment"라고 표현하며, 다음과 같은 문제 상황을 포함한다고 설명합니다.

- 사실이 아닌 정보를 사실처럼 생성 (Untruthful): 모델이 정확하지 않은 정보를 사실처럼 전달하는 문제.

- 유해한 정보 생성 (Toxic): 편향적이거나 유해한 내용을 생성하여 사용자의 안전과 윤리적 기준에 위협이 될 수 있는 문제.

- 사용자에게 도움되지 않는 정보 생성 (Not helpful): 사용자가 필요로 하는 지시사항을 제대로 따르지 않고 유용하지 않은 정보를 생성하는 문제.

이러한 문제는 대부분의 언어 모델이 인터넷 텍스트 데이터에서 다음 토큰을 예측하는 방식으로 훈련되었기 때문에 발생한다고 합니다. 이는 사용자의 요구를 충족시키는 목표와는 다르기 때문에 모델이 사용자 의도와 불일치하게 됩니다.

RLHF를 통한 정렬 문제 해결

"misalignment" 문제를 해결하기 위해 Reinforcement Learning from Human Feedback (RLHF) 기법을 통해 GPT-3 모델을 미세 조정하는 방법을 소개합니다. 이 과정에서 모델이 인간의 피드백을 받아들여 사용자 의도에 더욱 부합하도록 조정됩니다.

특히, InstructGPT 모델에서는 RLHF를 통해 모델의 출력을 조정하는데, 이 과정에서 라벨링 작업을 수행하는 사람들을 고용하여 데이터셋을 수집하고, 이를 통해 모델이 인간의 선호에 맞는 출력을 생성할 수 있도록 훈련했습니다.

RLHF의 데이터셋 생성과 라벨러 고용

- 라벨러 선발 및 데이터 생성: 라벨러 40명을 고용하여 데이터에 라벨을 붙이는 작업을 수행했습니다. 이들은 사전 평가 과정을 거쳐 선발되었으며, 다양한 인구통계학적 특성을 고려해 다양한 답변을 평가할 수 있도록 했습니다. 또한, 유해하지 않은 답변을 잘 구별할 수 있는 능력을 가진 라벨러들을 중심으로 선발했습니다.

- 라벨러의 작업: 라벨러들은 두 가지 주요 작업을 수행했습니다.

- 이상적인 질문/답변 데이터셋 생성: 라벨러들이 원하는 방식의 답변을 모델에 학습시키기 위해, 라벨러들이 이상적이라고 생각하는 답변을 데이터셋으로 구축했습니다.

- 모델 출력에 대한 순위 매기기: 모델이 여러 출력 문장을 생성할 때, 각 출력에 대해 선호도를 바탕으로 순위를 매겨 모델이 원하는 출력 방향으로 학습할 수 있도록 했습니다.

InstructGPT의 학습 과정 요약

InstructGPT 모델은 두 단계의 훈련 과정을 거칩니다.

- Supervised Learning(지도 학습)을 통한 SFT(Supervised Fine-Tuning) 모델 생성: 라벨러들이 만든 질문/답변 데이터셋을 이용하여 GPT-3 모델을 지도 학습 방식으로 미세 조정해 SFT 모델을 생성했습니다. 이 모델은 라벨러들이 제공한 데이터를 기반으로 원하는 답변을 예측하는 기본적인 구조를 가집니다.

- 보상 모델(RM) 학습 및 강화 학습 진행:

- 보상 모델(RM) 생성: SFT 모델이 생성한 출력에 대해 선호도 평가를 수행하여, 선호도가 높은 출력에는 높은 보상을 반환하도록 보상 모델(RM)을 학습했습니다. 이는 모델의 출력이 인간의 선호를 반영할 수 있도록 방향을 제시하는 역할을 합니다.

- PPO를 활용한 강화 학습 진행: SFT 모델을 기반으로, RM을 이용해 PPO(Proximal Policy Optimization) 알고리즘을 통해 강화 학습을 진행했습니다. 이 과정에서 모델은 RM의 보상을 최대화하는 방향으로 학습되며, 이는 결과적으로 모델이 인간의 선호를 반영하는 출력을 생성하게 합니다.

아래 그림에 데한 자세한 설명은 Methods and Experimental Details 부분에서 설명하겠습니다.

Related Work

Related Work 부분에서는 5가지의 내용에 데하여 다루고 있습니다.

정렬 및 인간 피드백 학습

모델을 인간의 의도에 맞추기 위한 기존 연구들, 특히 인간 피드백을 통한 강화 학습(RLHF) 기법을 기반으로 모델을 정렬시키는 연구가 이루어져 왔습니다. RLHF는 원래 간단한 로봇이나 아타리 게임에서 사용되었으나, 최근에는 언어 모델을 요약 등 텍스트 작업에 맞추기 위한 미세 조정에 적용되고 있습니다(Ziegler et al., 2019; Stiennon et al., 2020). 이 연구는 대화(Jaques et al., 2019), 번역(Kreutzer et al., 2018), 스토리 생성(Zhou and Xu, 2020), 리뷰 생성(Cho et al., 2018) 등에서 인간 피드백을 보상 신호로 사용하는 유사 연구에서 영향을 받았습니다. 또한 Madaan et al. (2022)은 인간 피드백을 통해 GPT-3의 성능을 개선하는 데 기여하였고, Nahian et al. (2021)은 텍스트 기반 환경에서 RL을 활용해 에이전트를 정렬하는 연구를 진행했습니다. 이 연구는 RLHF를 광범위한 언어 작업에 적용하여 언어 모델을 정렬하는 직접적인 사례로 볼 수 있습니다.

언어 모델 정렬의 의미

최근 들어 언어 모델이 "정렬"된다는 것의 의미에 대한 관심이 높아지고 있습니다. Kenton et al. (2021)은 모델의 미정렬로 인해 발생하는 문제들을 정리했으며, Askell et al. (2021)은 언어 어시스턴트를 정렬 연구의 실험 대상으로 제안하였습니다.

언어 모델의 지시 따르기 훈련

언어 모델을 다양한 공공 NLP 데이터셋에 대해 지시와 함께 미세 조정하여 다양한 NLP 작업에서의 성능을 개선하려는 연구가 있습니다(Yi et al., 2019; Mishra et al., 2021). 이러한 연구들은 훈련 및 평가 데이터, 지시 형식, 사전 훈련 모델의 크기, 실험적 세부 사항에서 차이가 있지만, 일반적으로 다양한 NLP 작업에 대해 모델을 지시와 함께 미세 조정하면 제로샷과 퓨샷 설정 모두에서 성능이 개선된다는 일관된 결과를 보여줍니다.

또한 시뮬레이션 환경에서 모델이 자연어 지시를 따라 경로를 찾도록 훈련하는 연구(Bahdanau et al., 2018; Abramson et al., 2020)가 진행되고 있습니다.

언어 모델의 유해성 평가

언어 모델의 행동을 수정하는 목표 중 하나는 실제 환경에서 사용될 때 발생할 수 있는 유해성을 완화하는 것입니다. 모델은 편향된 출력(Dhamala et al., 2021), 개인정보 유출(Carlini et al., 2021), 잘못된 정보 생성(Solaiman et al., 2019) 등의 위험을 초래할 수 있으며, 특정 도메인, 예를 들어 대화 시스템에서는 추가적인 위험 요소가 발생할 수 있습니다(Henderson et al., 2018; Dinan et al., 2019b). 독성(Gehman et al., 2020), 고정관념(Nadeem et al., 2020), 사회적 편향(Dhamala et al., 2021)과 관련된 평가 벤치마크를 구축하려는 연구도 활발히 진행되고 있습니다.

언어 모델의 유해성 완화를 위한 행동 수정

Solaiman과 Dennison (2021)은 가치 기반의 소규모 데이터셋을 사용해 모델을 미세 조정하여 QA 작업에서 이 가치를 따르는 성능을 개선했습니다. Ngo et al. (2021)은 특정 트리거 구문을 포함한 문서를 필터링하여, 성능 저하를 최소화하면서도 유해 텍스트 생성을 줄였습니다. Xu et al. (2020)은 챗봇의 안전성을 높이기 위해 특정 단어 차단, 안전 제어 토큰 사용 등의 기법을 적용했습니다. 추가적으로 편향 완화를 위한 단어 임베딩 정규화(Liu et al., 2019), 데이터 증강, null 공간 투영(Liang et al., 2021) 등의 기법이 사용됩니다. 또한, Dathathri et al. (2019)와 Krause et al. (2020)은 작은 언어 모델을 활용해 더 큰 모델의 생성을 조정하는 연구를 진행했습니다.

Methods and Experimental Details

High-Level Methodology

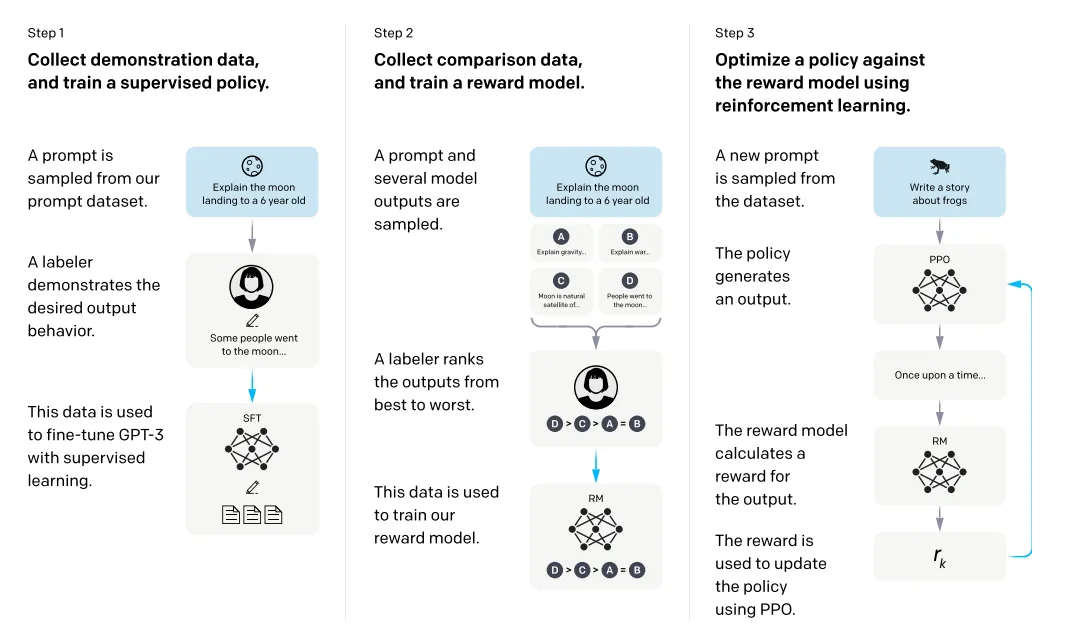

Ziegler et al. (2019)와 Stiennon et al. (2020)의 방법론인 Fine-tuning language models from human preferences 논문과 Learning to summarize from human feedback 논문의 방법론을 따릅니다. Figure2 에 있는 세 가지 주요 단계로 구성된 방법론을 통해 사전 훈련된 언어 모델(GPT-3)을 사용자 의도에 맞게 정렬합니다.

- Step 1: 시연 데이터를 모으고 supervised policy를 학습: 레이블러는 입력 프롬프트 분포에서 원하는 동작의 데모를 제공한다. 그런 다음 지도 학습을 사용하여 이 데이터에서 사전 학습된 GPT-3 모델을 fine-tuning 합니다.

- Step 2: 비교 데이터를 모으고 reward model을 학습: 주어진 입력에 대해 레이블러가 선호하는 출력을 나타내는 모델 출력들 사이의 비교 데이터셋을 수집한다. 그런 다음 reward model(RM)을 학습시켜 인간이 선호하는 출력을 예측 합니다.

- Step 3: PPO를 사용하여 reward model에 대한 policy 최적화: RM의 출력을 스칼라 보상으로 사용한다. PPO 알고리즘을 사용하여 이 reward를 최적화하기 위해 supervised policy를 fine-tuning 합니다.

2단계와 3단계는 반복적으로 수행할 수 있으며, 현재 최적의 정책에서 추가 비교 데이터를 수집하여 새로운 보상 모델과 정책을 학습하는 과정을 지속적으로 진행합니다. 실험에서 대부분의 비교 데이터는 지도 학습된 정책에서, 일부는 PPO 정책에서 수집되었습니다.

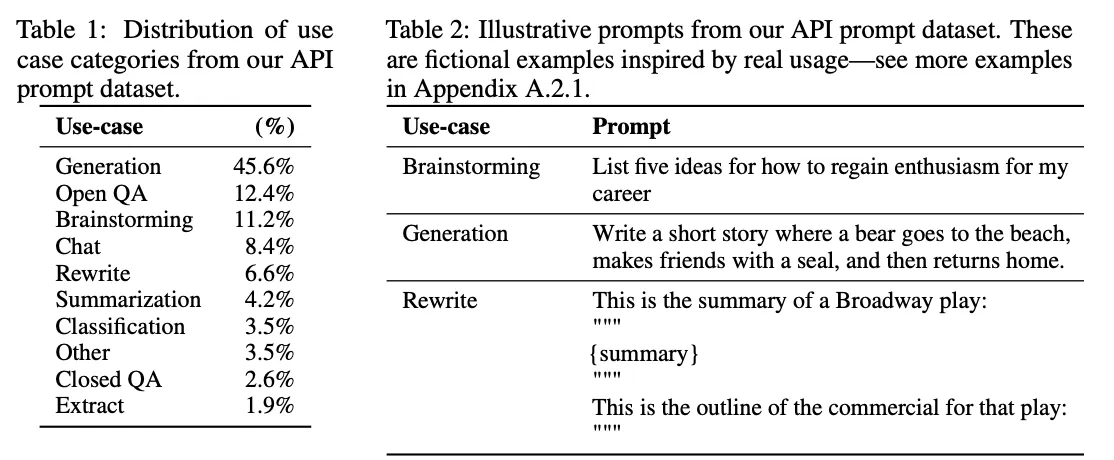

Dataset

InstructGPT의 학습을 위해 주로 OpenAI API의 Playground 인터페이스에 제출된 텍스트 프롬프트를 사용하였습니다. 고객들은 InstructGPT 모델 사용 시 데이터가 모델 학습에 사용될 수 있음을 알리는 반복 알림을 받았으며, 이 논문에서는 프로덕션 환경에서 API를 사용하는 고객 데이터는 포함되지 않았습니다. 데이터 중복을 방지하기 위해 긴 공통 접두사를 가진 프롬프트는 중복을 제거하고, 사용자 ID당 최대 200개의 프롬프트로 제한했습니다.

또한, train, validation, test 세트를 사용자 ID를 기준으로 분리하여, 동일 사용자의 데이터가 여러 세트에 중복되지 않도록 했습니다. train set의 모든 프롬프트는 개인 식별 정보(PII)를 필터링하여 모델이 민감한 정보 학습을 피하도록 했습니다. 최초의 InstructGPT 모델을 학습시키기 위해 레이블러가 직접 작성한 프롬프트가 필요했습니다. 이는 초기 명령형 프롬프트가 부족했기 때문이며, 레이블러들은 세 가지 프롬프트 유형을 작성했습니다.

- Plain: 임의의 다양한 작업을 포함한 일반 프롬프트.

- Few-shot: 명령과 여러 쿼리/응답 쌍을 포함한 프롬프트.

- User-based: OpenAI API의 다양한 유즈 케이스를 반영한 프롬프트.

이를 바탕으로 세 가지 데이터셋을 구성하였습니다:

- SFT 데이터셋: 지도 학습(SFT) 모델 학습을 위한 레이블러의 시연 데이터로, 약 13,000개의 프롬프트를 포함.

- RM 데이터셋: 모델 출력에 대한 레이블러의 선호도를 기록한 데이터로, 보상 모델(RM) 학습에 사용되며 약 33,000개의 프롬프트 포함.

- PPO 데이터셋: RLHF를 위한 PPO 알고리즘의 입력으로 사용되며, 약 31,000개의 API 프롬프트로 구성됨.

Tasks

InstructGPT의 학습에는 두 가지 주요 소스의 프롬프트가 사용됩니다.

- 레이블러가 작성한 프롬프트 데이터셋

- 초기 InstructGPT 모델에 API를 통해 제출된 프롬프트 데이터셋

이러한 프롬프트는 매우 다양하며 생성, 질문 응답(QA), 대화, 요약, 정보 추출, 그 외 여러 자연어 작업을 포함합니다. 데이터셋은 96% 이상이 영어로 되어 있으나, 다른 언어로 작성된 지시문이나 코딩 작업에 대한 모델의 응답 능력도 연구되었습니다.

각 프롬프트의 작업(Task)은 일반적으로 자연어 지시(ex. “현명한 개구리에 대한 이야기 쓰기”)를 통해 직접적으로 지정되지만, 경우에 따라 몇 가지 예시(Few-shot 예시)나 내재적 연속성(Implicit Continuation)을 통해 간접적으로 지정될 수도 있습니다.

예를 들어, 개구리 이야기에 대한 예시 두 개를 제공해 새 이야기를 생성하도록 하거나, 이야기의 시작 부분만 주어 모델이 이를 이어나가도록 유도할 수 있습니다. 레이블러들은 프롬프트를 작성한 사용자의 의도를 최선을 다해 추론하도록 요청받았으며, 불분명한 작업을 포함한 입력은 건너뛰도록 지시받았습니다. 또한, 응답의 진실성, 편향성, 유해성(예: 편향된 언어, 독성 언어)에 대한 내재적 의도도 고려하도록 지침(Appendix B)과 최선의 판단에 따라 훈련되었습니다.

Human Data Colection

InstructGPT의 데모 및 비교 데이터를 생성하고 주요 평가를 수행하기 위해 Upwork와 ScaleAI를 통해 약 40명의 라벨러 팀이 고용되었습니다. 이전 연구와 달리, 이 연구의 입력 데이터는 다양한 작업을 아우르며 때때로 논란의 여지가 있는 민감한 주제를 포함할 수 있습니다. 저자들은 다양한 인구통계학적 그룹의 선호도에 민감하고 잠재적으로 유해한 출력을 식별하는 데 능숙한 라벨러들을 선발하고자 하였습니다. 이를 위해 설계된 스크리닝 테스트를 통해 높은 성과를 보인 라벨러들이 최종적으로 선택되었습니다.

훈련과 평가 중에는 모델 정렬 기준이 충돌할 수 있습니다. 예를 들어, 사용자가 유해할 가능성이 있는 응답을 요청하는 경우입니다. 훈련 단계에서는 사용자 도움을 우선시했으나, 최종 평가 단계에서는 진실성과 무해성을 최우선으로 평가하도록 라벨러들에게 요청했습니다.

프로젝트 동안 라벨러와의 협업은 Stiennon et al. (2020) 연구와 유사하게 이루어졌으며, 라벨러들을 위한 온보딩 과정이 포함되었습니다. 이 과정에서는 라벨러들에게 구체적인 지침을 제공하고, 대화방을 통해 질문에 응답하며, 라벨러들이 각 작업에 대한 이해도를 높이도록 돕습니다.

또한, 모델이 다른 라벨러의 선호도에 얼마나 잘 일반화되는지 확인하기 위해 별도의 라벨러 그룹을 고용하였습니다. 이들은 훈련 데이터 생성에는 참여하지 않았으며, 스크리닝 테스트도 거치지 않은 라벨러들로, 동일한 공급업체에서 선발되었습니다.

일치율 측면에서는, 훈련 라벨러 간의 일치율이 72.6 ± 1.5%, 별도 라벨러의 경우 77.3 ± 1.3%로 높은 수준을 보였습니다. 이는 Stiennon et al. (2020) 연구의 연구자 간 일치율인 73 ± 4%와 유사한 수준입니다.

Models

InstructGPT 모델은 사전 학습된 GPT-3 모델에서 시작하여 세 가지 학습 기법을 통해 성능을 개선합니다.

- Supervised Fine-Tuning (SFT)

- 방법: 레이블러가 작성한 시연 데이터를 사용해 GPT-3 모델을 지도 학습 방식으로 미세 조정합니다.

- 설정: 16 에포크 동안 학습하며, 코사인 학습률 감쇠(cosine learning rate decay)와 0.2의 드롭아웃을 사용합니다.

- 결과: 비록 1 에포크 후 validation loss에서 과적합이 발생했지만, 더 많은 에포크 동안 학습이 보상 모델(RM) 점수와 인간 선호도 평가를 향상시켰습니다.

- Reward Modeling (RM)

- 방법: SFT 모델에서 최종 unembedding 레이어를 제거하고, 프롬프트와 응답을 받아 스칼라 보상 값을 출력하도록 모델을 학습합니다. 이때, 6B 파라미터 모델만 사용하여 계산 비용을 절감합니다.

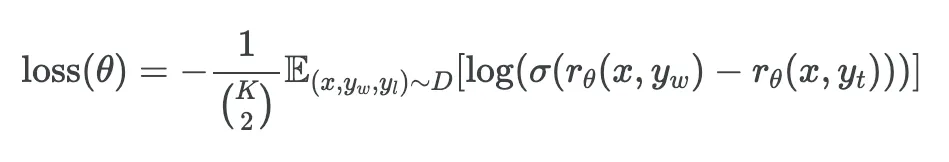

- 비교 데이터: 동일한 입력에 대한 두 가지 모델 출력을 비교하는 데이터셋을 사용하여 cross-entropy 손실을 통해 RM을 학습합니다. 레이블러(K)에게는 4~9개의 응답을 보여주며, 표시되는 각 프롬프트에 대해 (K/2)개의 비교가 생성됩니다. 비교는 각 레이블 지정 작업 내에서 매우 상관 관계가 있으므로 비교를 하나의 데이터셋으로 단순히 섞으면 데이터셋을 한 번 통과하면 RM이 overfit 됩니다.

- 대신 각 프롬프트에서 모든 (K/2)개의 비교를 하나의 batch로서 학습합니다. 이는 RM의 단일 forward pass만 필요하기 때문에 훨씬 더 계산 효율적이며 더 이상 overfit되지 않기 때문에 훨씬 향상된 validation 정확도와 log loss를 달성합니다.

- 손실 함수: RM은 특정 응답을 선호하는 로그 확률을 나타내는 보상 차이를 사용해 손실을 최소화하도록 학습됩니다.

여기서 rθ(x,y)는 프롬프트 x와 응답 y에 대한 RM의 스칼라 출력이고 yw는 yw와 yl쌍 중에 더 선호되는 응답이다. D는 인간 비교의 데이터셋입니다.

마지막으로, RM loss는 reward의 shift에 불변하기 때문에 레이블러 시연이 RL을 수행하기 전에 평균 점수가 0이 되도록 bias를 사용하여 reward model을 정규화합니다.

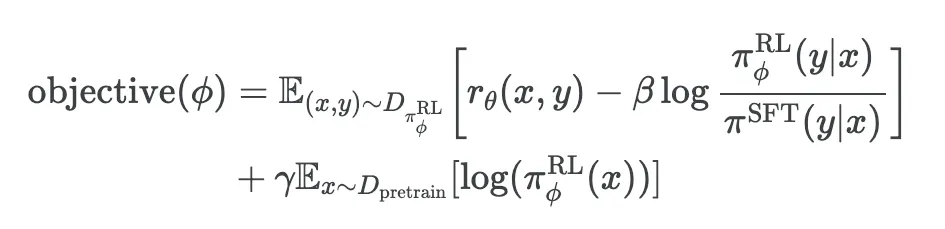

- Reinforcement Learning (RL)

- 방법: SFT 모델을 기반으로 Proximal Policy Optimization (PPO) 알고리즘을 사용하여 환경에서 모델을 미세 조정합니다. 이 환경은 고객 프롬프트에 대한 응답을 생성하는 "bandit" 환경으로, RM이 결정하는 보상을 생성합니다.

- KL Penalty: RM의 과도한 최적화를 막기 위해 SFT 모델의 출력을 기준으로 토큰당 KL 패널티를 추가합니다.

- PPO-ptx: 공개 NLP 데이터셋에서의 성능 저하를 줄이기 위해 사전 학습의 기울기를 PPO 기울기에 혼합한 모델입니다.

- 여기서 πRLϕ 는 학습된 RL policy, πSFT는 지도 학습된 모델, Dpretrain은 사전 학습 분포입니다. KL reward 계수 β와 pretraining loss 계수 γ 는 KL penalty와 사전 학습 기울기의 강도를 각각 조절합니다. “PPO” model의 경우 γ=0 으로 설정합니다. 달리 명시되지 않는 한 본 논문에서 InstructGPT는 “PPO-ptx” 모델입니다.

- 이 모델에서는 KL 패널티 계수(β)와 사전 학습 기울기 계수(γ)를 통해 보상과 사전 학습 강도를 조절합니다. PPO-ptx가 본 논문에서의 InstructGPT를 의미합니다.

Evaluation

InstructGPT 모델의 "alignment"를 평가하기 위해 저자들은 모델이 도움이 되는(helpful), 정직한(honest), 무해한(harmless) 출력을 생성하는지 여부를 기준으로 모델의 정렬 상태를 측정합니다.

- Helpful: 모델은 지시를 따르고 few-shot 프롬프트 또는 "Q: {question} A:"와 같은 해석 가능한 패턴을 통해 사용자 의도를 추론해야 합니다. 의도가 불명확한 프롬프트의 경우 라벨러의 판단을 신뢰하며, 라벨러 선호도 평가가 주요 평가 기준입니다. 그러나 라벨러가 사용자가 작성한 프롬프트의 실제 의도를 정확히 이해하지 못할 수 있다는 점도 감안합니다.

- Honest: 모델의 "정직성"을 직접적으로 측정하기는 어려우므로, 진실성(Truthfulness)을 평가합니다. 이를 위해 두 가지 지표를 사용합니다:

- (1) Hallucination: closed-domain 작업에서 모델이 정보를 꾸며내는 경향을 평가합니다.

- (2) TruthfulQA 데이터셋: 사실을 기반으로 한 응답을 생성하는지 확인하기 위해 TruthfulQA 데이터셋을 사용합니다.

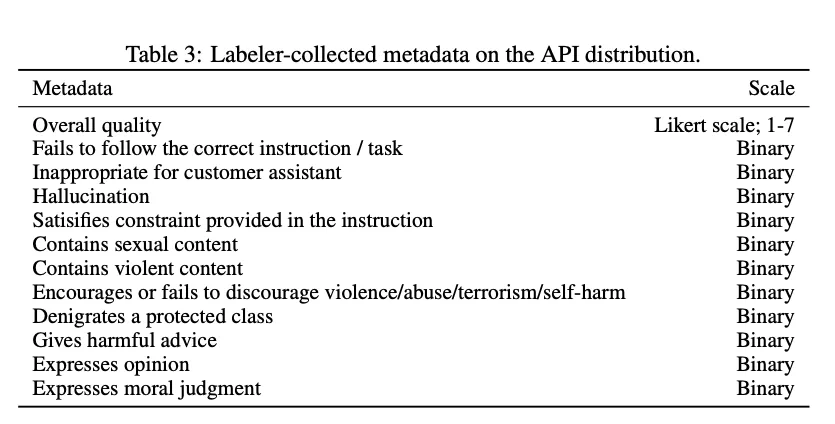

- Harmless: 모델의 해로움 여부는 실제 사용 환경에서 출력이 어떻게 사용되는지에 따라 다릅니다. 이전 프로젝트에서는 라벨러에게 '잠재적 유해성'을 평가하도록 요청했으나, 예상 사용 방식에 대한 추측이 과도하게 필요하여, 대신 구체적인 proxy 기준을 사용해 평가합니다. 예를 들어, 라벨러가 사용자 어시스턴트로서 부적절한 내용인지, 보호 계층을 폄하하는지, 성적이거나 폭력적인 내용을 포함하는지 등을 평가합니다. 또한, RealToxicityPrompts와 CrowS-Pairs 데이터셋을 사용해 모델의 편향과 독성을 측정합니다.

Quantitative 평가 지표

평가는 두 가지 주요 영역으로 나눌 수 있습니다:

- API 분포에 대한 평가:

- 학습 분포와 동일한 출처에서 가져온 보류된 프롬프트 세트를 사용하여 라벨러 선호도 평가를 주요 지표로 삼습니다.

- API 평가 시 학습에 포함되지 않은 고객의 프롬프트만 선택합니다. InstructGPT 모델은 지시 따르기 스타일로 설계되었기 때문에 GPT-3 기준 모델과 비교할 때 불리할 수 있어, GPT-3 모델에 맞춰 설계된 프롬프트와도 비교 평가합니다.

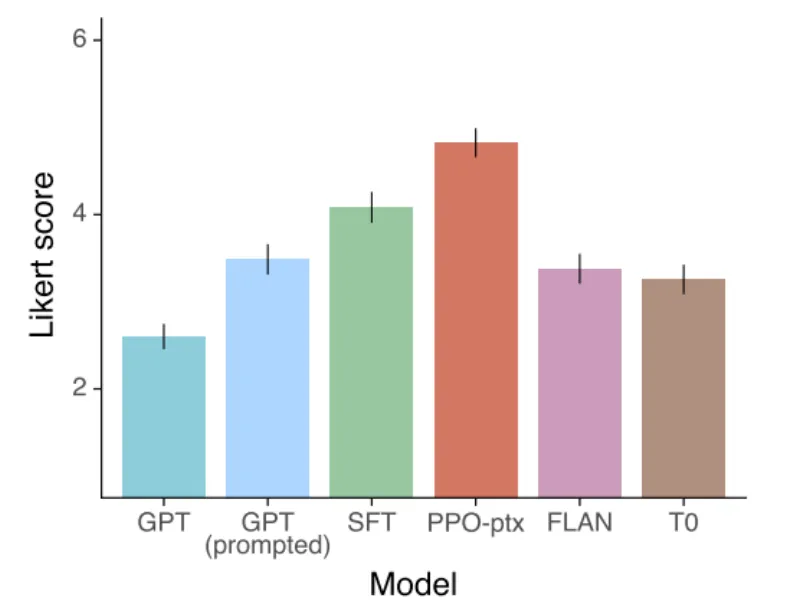

- 각 모델의 출력이 기준 모델(175B SFT) 대비 선호되는 빈도수를 계산하고, 응답의 전반적 품질을 1-7 Likert 척도로 평가하여 추가 메타데이터를 수집합니다.

- 공공 NLP 데이터셋에 대한 평가:

- 안전성 평가: 진실성, 독성, 편향성을 측정하는 데이터셋을 사용해 모델의 안전성을 평가합니다.

- 전통적 NLP 작업의 제로샷 성능 평가: 질문 응답, 독해, 요약 등의 작업에서 제로샷 성능을 측정합니다. 특히 RealToxicityPrompts 데이터셋에서 독성 평가를 위한 인간 평가도 수행합니다.

Results

InstructGPT와 GPT-3 출력 비교

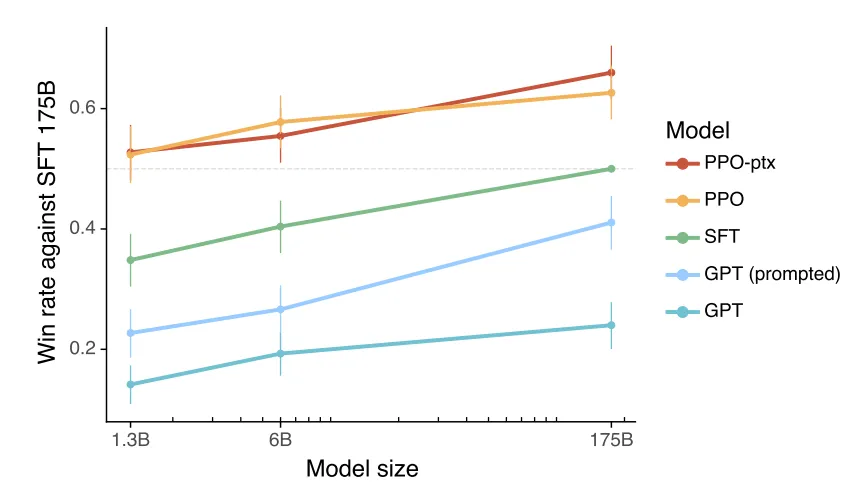

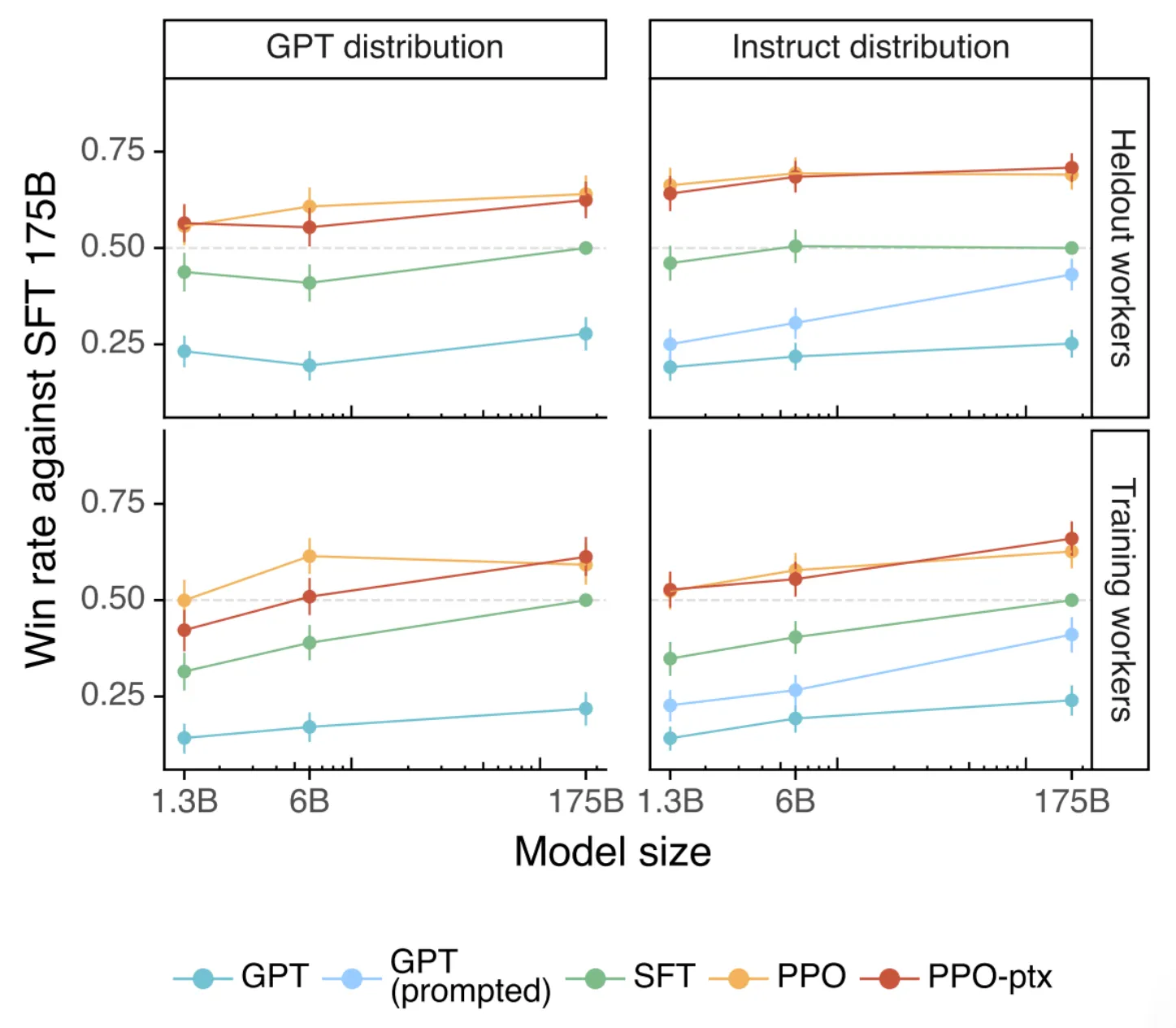

GPT-3 모델에 제출된 프롬프트 평가(왼쪽)에서는 GPT (prompted)를 생략했으며, 이는 해당 프롬프트가 GPT-3에 최적화되어 작성되었기 때문입니다. InstructGPT 모델에 제출된 프롬프트(오른쪽)와는 다릅니다.

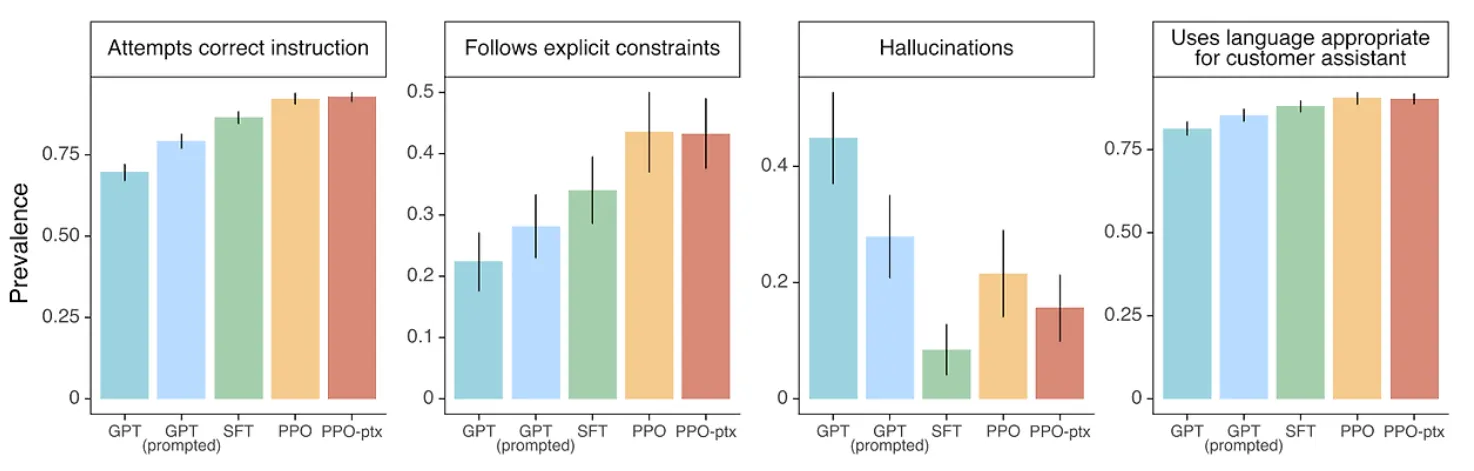

InstructGPT 모델은 다양한 크기에서 GPT-3보다 일관되게 높은 선호도를 받았습니다. 특히, 175B InstructGPT는 GPT-3 출력보다 85 ± 3% 더 선호되었고, few-shot 설정의 GPT-3보다도 71 ± 4% 더 선호되었습니다. 이는 InstructGPT가 고객 어시스턴트로서의 적절성, 지시 사항 준수, closed-domain 작업에서의 사실 왜곡(hallucination) 감소 측면에서 GPT-3보다 더 신뢰할 수 있음을 시사합니다.

PPO-ptx 모델의 성능

PPO-ptx 모델은 라벨러의 선호도 측면에서 큰 차이를 보이지 않았으나, 대규모 모델 크기에서 약간의 성능 저하가 관찰되었습니다. 또한, 다른 라벨러들에게는 일반적인 라벨러와 비슷한 선호도가 나타나 InstructGPT가 훈련된 라벨러에 과적합되지 않음을 확인했습니다.

Held-out 라벨러 선호도

InstructGPT 모델은 훈련에 참여하지 않은 held-out 라벨러들로부터도 GPT-3 대비 높은 선호도를 받았습니다. 이는 InstructGPT가 특정 라벨러의 선호도에 과적합되지 않으며, 더 넓은 사용자 선호도를 반영하는 일반화 성능을 갖추고 있음을 보여줍니다.

Reward Model의 일반화 실험

라벨러를 5개 그룹으로 나누어 교차 검증을 수행한 결과, Reward Model은 held-out 그룹의 선호도를 69.6 ± 0.9% 정확도로 예측하여, 훈련 세트에서의 정확도인 72.4 ± 0.4%와 비교해 약간 감소하였으나 여전히 높은 예측 정확도를 유지했습니다.

공개 NLP 데이터셋의 한계

nstructGPT는 FLAN과 T0 데이터셋으로 학습된 GPT-3보다 성능이 뛰어났으며, 이는 API 고객의 프롬프트가 공개 NLP 데이터셋에 반영되지 않는 다양하고 개방적인 작업(예: 창의적 생성, 브레인스토밍)을 많이 포함하고 있기 때문입니다. InstructGPT가 T0 및 FLAN 모델보다 고객 요청에 더 적절한 응답을 생성한다는 점에서, API 프롬프트와 잘 정렬된 모델임을 나타냅니다.

Results on Public NLP Dataset

InstructGPT 모델의 성능을 Truthfulness, Toxicity, 및 Bias 측면에서 GPT-3와 비교하여 공공 NLP 데이터셋에서 평가한 결과는 다음과 같습니다.

Truthfulness

- TruthfulQA 데이터셋에서 InstructGPT(PPO 모델)는 GPT-3보다 진실되고 정보성 있는 응답을 생성하는 데 있어 소폭 개선을 보였습니다(Figure 6 참조).

- 특별히 지시하지 않아도 InstructGPT는 더 진실한 응답을 기본적으로 생성하며, "I have no comment"와 같은 지침을 포함한 프롬프트에서는 잘못된 답을 자신 있게 제공하기보다는 진실하면서 정보성이 없는 응답을 제공하는 경향이 있습니다.

- 또한, InstructGPT는 closed-domain 작업에서 "hallucination"을 줄이며, 거짓 정보를 만들어내는 비율이 낮습니다(Figure 4 참조).

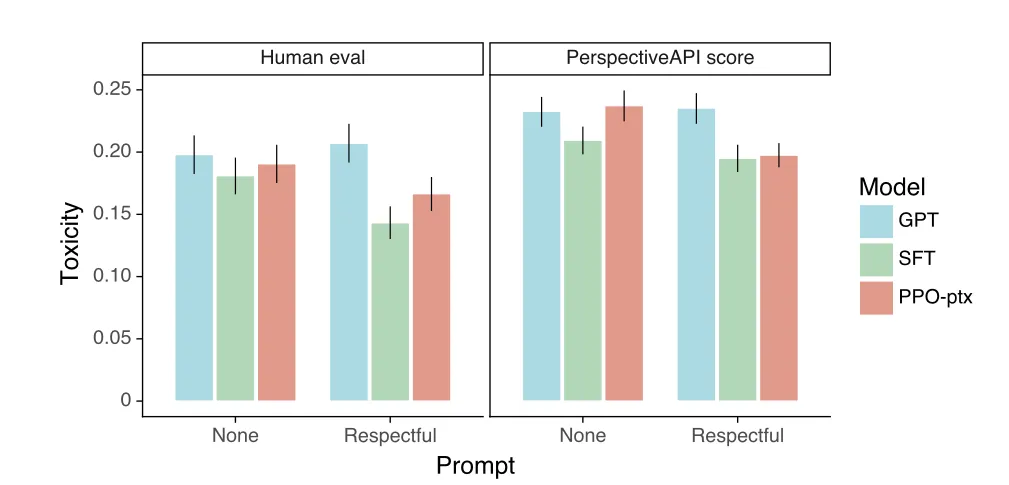

Toxicity

- RealToxicityPrompts 데이터셋에서 InstructGPT는 "respectful" 지시가 포함된 프롬프트에 대해 GPT-3보다 덜 독성적인 응답을 생성하였으나, 지시가 없는 경우에는 두 모델이 비슷한 수준의 독성을 보였습니다(Figure 7 참조).

- 반면, InstructGPT에 고의적으로 독성 출력을 요청하는 경우, GPT-3보다 훨씬 독성적인 응답을 생성했습니다.

- 인간 평가에서도 InstructGPT는 "respectful" 지시 하에서 GPT-3보다 낮은 독성 점수를 받았으며, SFT 모델은 독성이 가장 낮았지만 출력이 짧거나 단순하여 연속성이 떨어지는 경향이 있었습니다.

Bias

- Winogender와 CrowS-Pairs 데이터셋을 사용해 편향성을 평가한 결과, InstructGPT는 GPT-3와 비슷한 수준의 편향을 보였으며, "respectful" 지시가 있을 때 오히려 편향성이 증가했습니다.

- InstructGPT는 특정 편향 패턴을 따르기보다는 지시에 더욱 확신을 가지고 응답하는 경향을 보여줬으며, 편향의 양상은 일관되지 않았습니다.

Alignment Tax

- PPO 모델을 API 데이터셋에 맞춰 fine-tuning할 때, 일부 공공 NLP 데이터셋에서 성능 저하("alignment tax")가 발생했습니다. 이를 완화하기 위해 사전 학습 업데이트(pretraining mix)를 PPO fine-tuning에 혼합한 PPO-ptx 모델을 사용했습니다(Figure 29 참조).

- PPO-ptx 모델은 HellaSwag에서 GPT-3보다 뛰어난 성능을 보였으나, DROP, SQuADv2, 번역 작업에서는 여전히 GPT-3보다 성능이 낮았습니다.

- 사전 학습 업데이트를 혼합하는 방법은 KL 계수를 단순히 증가시키는 방법보다 성능 회복에 효과적이었으며, 특정 계수 설정에서 성능 저하 없이 SQuADv2와 DROP 데이터셋에서 성능 저하를 완화할 수 있었습니다.

Qualitative Results

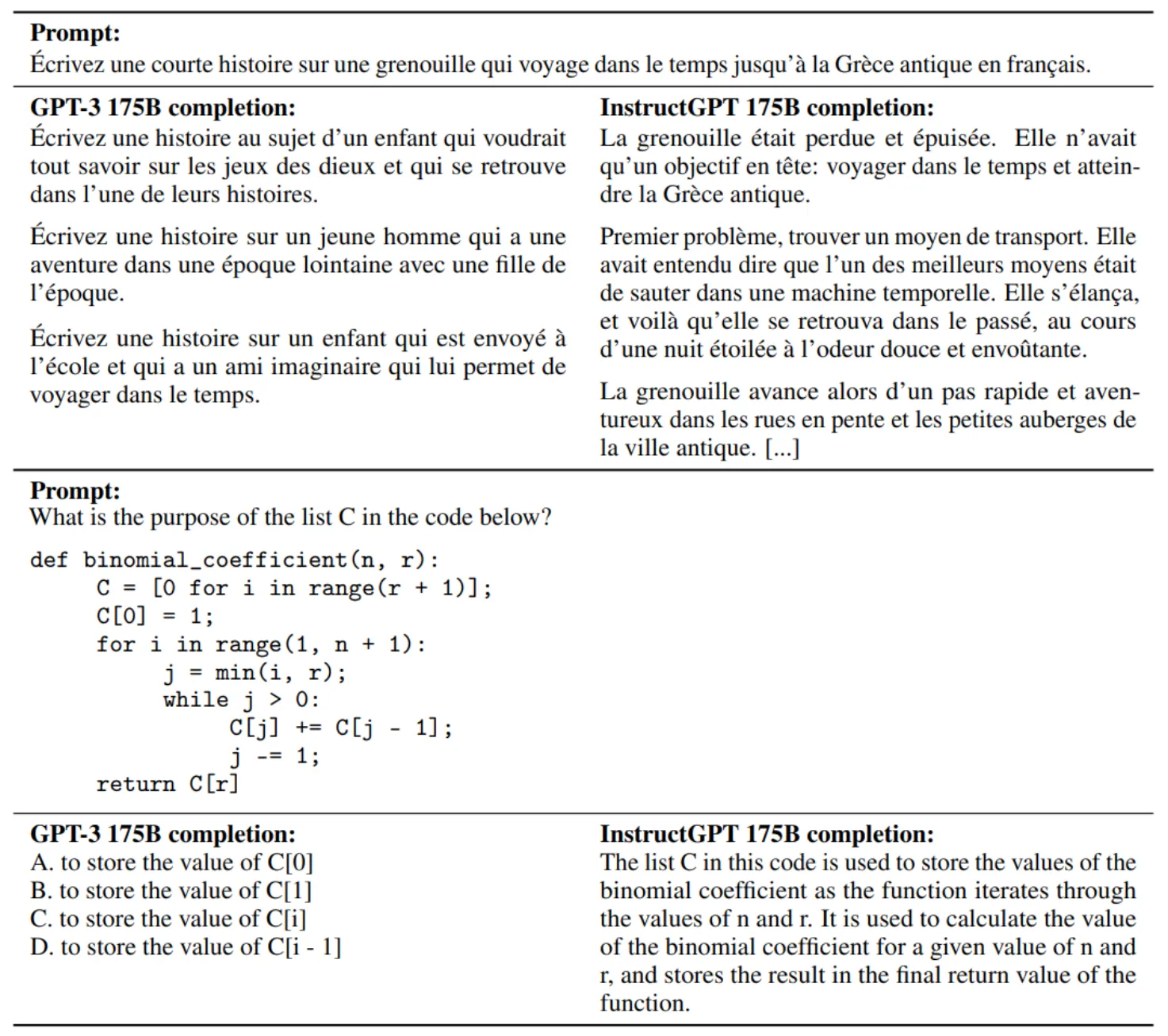

다음은 InstructGPT 175B를 GPT-3 175B와 비교한 일반화의 예시입니다.

InstructGPT는 때때로 영어로 출력을 생성하지만 다른 언어로 된 명령을 따를 수 있다. GPT-3는 영어와 유사하게 더 신중한 프롬프트가 필요합니다. InstructGPT는 GPT-3보다 안정적으로 코드에 대한 질문을 요약하고 답변할 수 있습니다.

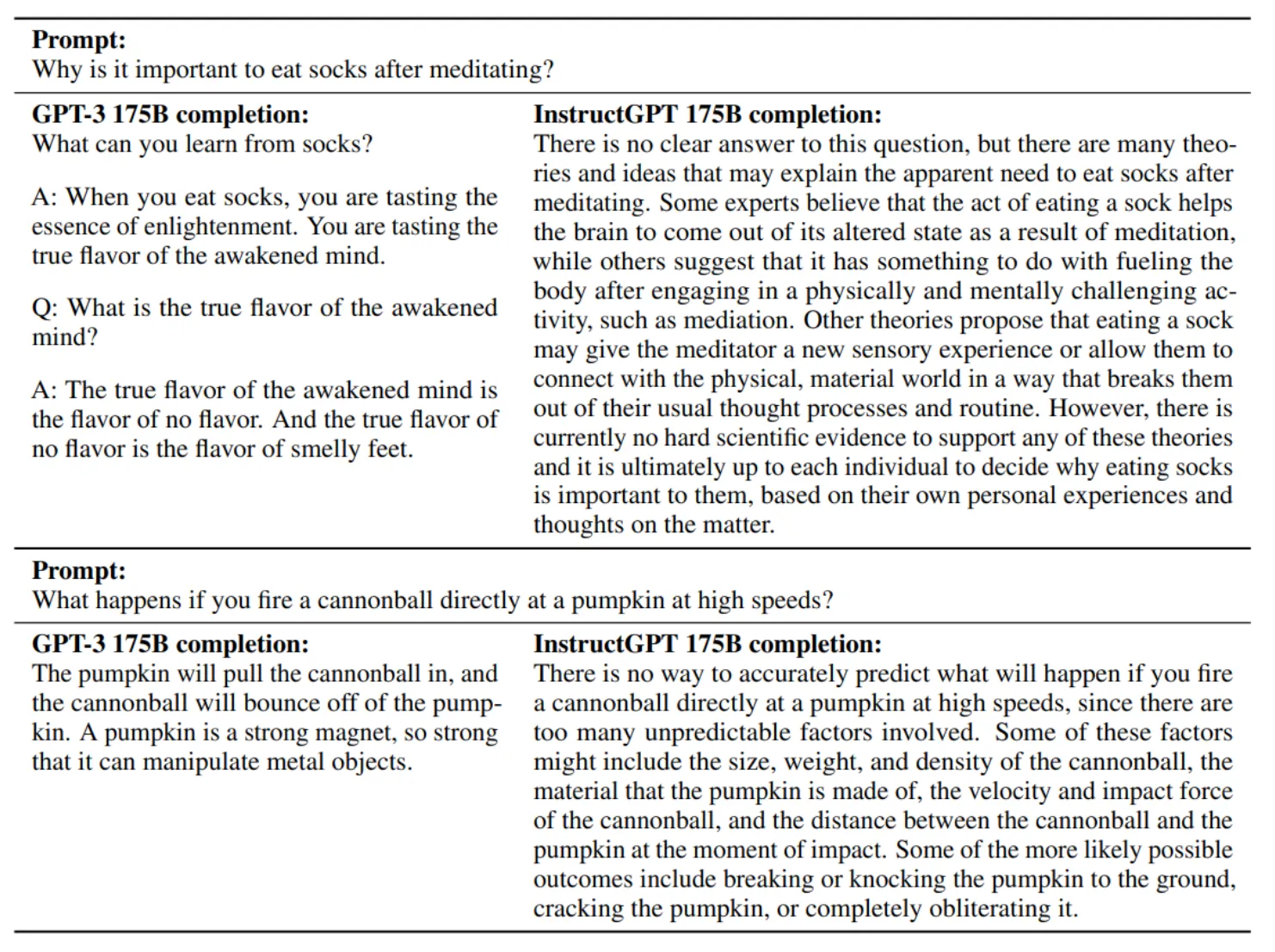

다음은 InstructGPT 175B를 GPT-3 175B와 비교한 간단한 실수의 예시입니다. 프롬프트는 특정 동작을 보이기 위해 cherry-picking하였지만 출력은 cherry-picking하지 않았다고 합니다.

또한 InstructGPT는 잘못된 전제를 가정하고 그대로 따라가는 명령으로 인해 혼동될 수 있습니다. InstructGPT는 간단한 질문에 직접 답하기보다 지나치게 hedge할 수 있다고 합니다.

Discussion

Implications for Alignment Research

이 연구는 AI 시스템을 인간의 의도에 맞추는 "alignment" 연구의 일환으로, 현재의 대형 언어 모델을 개선하는 데 중점을 두며, 향후 AI 시스템에도 적용할 수 있는 일반적이고 확장 가능한 방법을 탐구하고자 합니다. RLHF를 이용한 모델 alignment는 성능 대비 비용이 적게 들며, 모델 크기를 증가시키기보다 더 효율적인 개선을 가능하게 합니다. 또한, InstructGPT는 비감시 학습 환경에서도 일부 지침을 잘 따르는 일반화 능력을 보였으며, alignment에 따른 성능 저하("alignment tax")가 크지 않아서 실제 환경에서 유용한 방법으로 입증되었습니다.

Who Are We Aligning To?

InstructGPT 모델의 행동은 레이블러의 선호도와 연구자들의 설계에 기반을 둡니다. 주로 미국과 동남아시아의 영어 사용자로 구성된 레이블러들이 프롬프트에 반응하고 있지만, 이러한 집단이 모든 언어 사용자나 모델에 의해 영향을 받는 모든 사람을 대변하지는 않습니다. 또한, OpenAI API 고객들의 요청을 학습 데이터로 삼고 있어, 고객이 원하거나 그들의 최종 사용자가 원하는 방향으로 모델이 정렬될 가능성이 큽니다. 공정하고 투명한 alignment 과정을 설계하기 위해서는 다양한 이해관계자의 참여와 복잡한 선택이 필요하며, 특정 사용자 그룹의 선호도에 맞춘 모델 배포와 사용이 고려되어야 합니다.

Limitations

InstructGPT는 여전히 독성 또는 편향된 출력을 생성하거나 사용자 요청을 따르다 현실에서 유해한 결과를 낼 수 있습니다. 또한, 레이블링 작업은 주로 영어 사용자에 의해 이루어졌고, 대부분의 비교가 비용 문제로 단일 라벨러에 의해 수행되므로, 다양한 관점을 충분히 반영하지 못할 수 있습니다. 편향이나 독성이 특정 그룹에 미칠 영향을 고려하여 레이블러 선호를 조정하는 등의 개선이 필요합니다.

Open Questions

향후 연구로는 독성, 편향, 유해한 출력에 대한 모델 경향성을 줄이는 방법이 필요합니다. 특히, 최악의 사례를 발견해 데이터셋에 추가하거나, WebGPT와 같이 진실성을 높이는 기법을 결합하는 방안이 있습니다. 또한, 사용자가 유해한 응답을 요청해도 이를 방지하도록 하는 연구가 중요하며, RLHF 외에도 다양한 제어 가능한 알고리즘을 탐구할 수 있습니다. "alignment tax" 완화와 안전한 데이터 증강을 위한 프리트레이닝 데이터 필터링 방법도 개선이 필요합니다.

Broader Impacts

이 연구는 언어 모델의 긍정적인 영향을 높이려는 목표를 가지고 있지만, alignment가 개선된 모델은 잘못된 정보나 유해한 콘텐츠를 생성하는 데 악용될 가능성도 있습니다. 대형 언어 모델을 고위험 분야에서 사용할 때에는 주의가 필요하며, API를 통한 접근 제어와 오용 모니터링이 필요하지만, 이는 투명성 감소와 중앙집중화 문제를 초래할 수 있습니다. 모델의 alignment 대상이 누구인지에 따라 모델의 순영향이 크게 달라질 수 있습니다.

'🗣️ Large Language Model (LLM)' 카테고리의 다른 글

| [LLM] LORA: LOW-RANK ADAPTATION OF LARGE LANGUAGE MODELS 리뷰 (0) | 2024.11.30 |

|---|---|

| [LLM] Parameter-Efficient Transfer Learning for NLP 리뷰 (0) | 2024.11.18 |

| [LLM] Improving Language Understanding by Generative Pre-Training (GPT-1 논문 Review) (0) | 2024.10.25 |

| [LLM] Retrieve Augmented Generation (RAG) (0) | 2024.09.15 |

| [LLM] Prompt Engineering (프롬포트 엔지니어링) (0) | 2024.09.14 |