딥러닝 기반 자연어 처리 모델

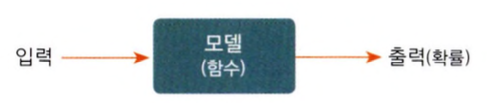

💡 모델(Model): 입력을 받아 어떤 처리를 수행하는 함수, 자연어처리에서의 input은 자연어

💡 모델의 출력은 확률이라는 점에 주목을 해야한다.

- 자연어처리 모델의 출력도 확률 → 그러나, 모델의 출력 형태는 확률, 사람이 원하는건 자연어 형태.

- 그러면 출력된 확률을 후처리 해서 자연어 형태로 변환을 해야한다.

- 딥러닝 모델에서는 데이터에 ‘감성’ 이라는 레이블을 달아 놓은 데이터가 있어야 한다. → 이걸 학습 데이터 라고 한다.

- 그리고 모델이 데이터의 패턴을 스스로 익히게 하는 과정 → 학습(train)

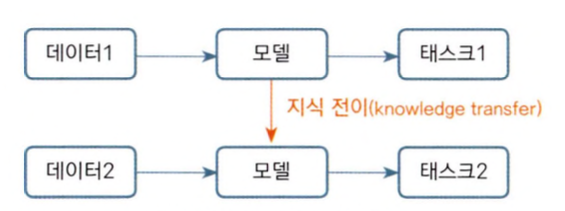

Transfer Learning

💡 트랜스퍼 러닝: 특정 Task를 학습한 모델을 다른 테스크 수행에 재사용하는 기법을 가리킴

- 트랜스퍼 적용시 기존보다 모델의 학습 속도 빨리짐, 새로운 태스크를 더 잘 수행하는 경향이 있음

- 태스크1: 업스트림(pre-train)

- 태스크2: 다운스트림

업스트림 태스크

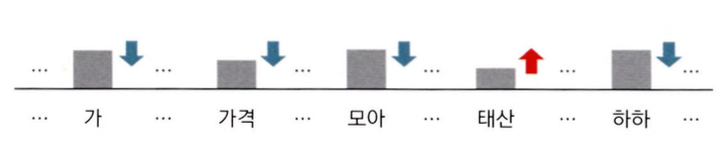

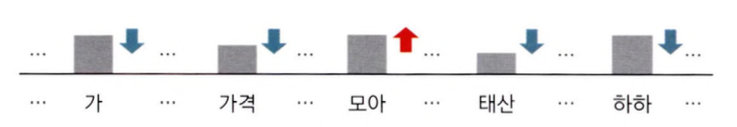

- 다음단어 맞히기. 이걸 수행한 모델을 언어모델(Language Model)

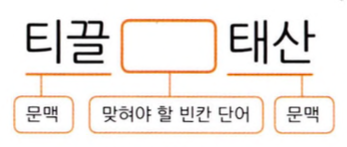

- 빈칸채우기: Bert 계열 모델이 이 태스크로 Pre-Train 수행 → 빈칸채우기로 업스트림 테스트 수행모델(Masked 언어 모델)

💡 이렇게 사람이 일일이 정답(Label)을 만든 데이터로 모델을 학습하는 방식 → 지도 학습 방식 (Supervised Learning)

다운스트림 태스크 - 자연어 처리의 구체적인 과제물

💡 Main Task → 분류: Classification

- 문서 분류: 자연어를 입력받아 해당 input이 긍,부정, 중립인지 그 확률값 반환

- 자연어 추론: 문장 2개를 입력받아 두 문장 사이 관계가 참, 거짓, 중립인지 확률값 반환

3. 객체명 인식: 자연어를 입력받아 단어별로 어떤 객체 범주에 속하는지 확률값 반환

4. 질의응답: 자연어(질문+지문)을 입력받아 각 단어가 정답의 시작일 확률값과 끝일 확률값 반환

5. 문장생성: 자연어를 입력받아 어휘 전체에 대한 확률값 반환

학습 파이프라인 소개

1. 설정값 선언

- 모델을 만들려면 → 설정값을 정해야 한다. 어떤 프리트레인 모델을 사용할지, 학습에 사용할 데이터는 무엇인지, 학습 결과는 어디에 저장할지 등…

- 이 설정값들은 본격적인 학습에 앞서 미리 선언해둔다

- 하이퍼파라미터(hyperparameter) 역시 미리 정해둬야 하는 중요한 정보

💡 하이퍼파라미터란 모델 구조와 학습 등에 직접 관계된 설정값을 가리킵니다.→ 러닝 레이트(learning rate), 배치 크기(batch size) 등이 있습니다.

- 설치 해야하는 라이브러리

!pip install ratsnlp

!pip install nlpbookfrom ratsnlp.nlpbook.classification import ClassificationTrainArguments

args = ClassificationTrainArguments(

pretrained_model_name="beomi/kcbert-base",

downstream_corpus_name="nsmc",

downstream_corpus_root_dir="/content/Korpora",

downstream_model_dir="/gdrive/My Drive/nlpbook/checkpoint-cls",

learning_rate=5e-5,

batch_size=32,

)2. 데이터 다운로드

- downstream_corpus_name(nsmc)에 해당하는 말뭉치를 코랩 환경 로컬의 downstream_corpus_root_dir(/content/Korpora) 아래에 저장

from Korpora import Korpora

Korpora.fetch(

corpus_name=args.downstream_corpus_name,

root_dir=args.downstream_corpus_root_dir,

force_download=True,

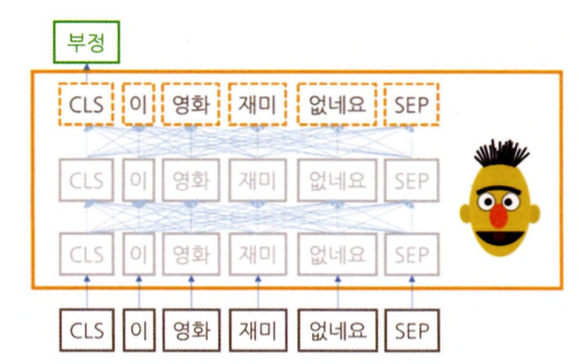

)3. KCBert-Base 모델 준비

- 대규모 말뭉치를 활용한 프리트레인에는 많은 리소스가 필요

- BERT, GPT 같은 트랜스포머(Transformer) 계열 모델→ 이 패키지를 쓰면 단 몇 줄만으로 모델을 사용가능

from transformers import BertConfig, BertForSequenceClassification

pretrained_model_config = BertConfig.from_pretrained(

args.pretrained_model_name,

num_labels=2,

)

model = BertForSequenceClassification.from_pretrained(

args.pretrained_model_name,

config=pretrained_model_config,

)4. Tokenizer 준비

- 자연어 처리 모델의 입력은 대개 토큰(token) → 문장(sentence)보다 작은 단위

- 한 문장은 여러 개의 토큰으로 구성

- 토큰 분리 기준은 그때그때 다를 수 있다. 문장을 띄어쓰기만으로 나눌 수도 있고, 의미의 최소 단위인 형태소(morpheme) 단위로 분리할 수도 있다.

💡 문장을 토큰 시퀀스(token sequence)로 분석하는 과정을 토큰화(tokenization), 토큰화를 수행하는 프로그램은 토크나이저(tokenizer)

from transformers import BertTokenizer

tokenizer = BertTokenizer.from_pretrained(

args.pretrained_model_name,

do_lower_case=False,

)5. DataLoader 준비

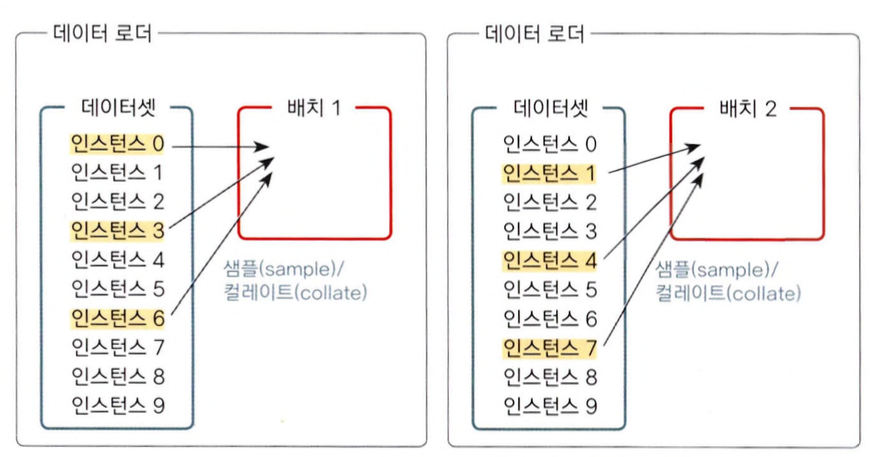

- 파이토치(PyTorch)는 딥러닝 모델 학습을 지원하는 파이썬 라이브러리 → 데이터 로더(DataLoader)라는 게 포함되어 있음

💡 파이토치로 딥러닝 모델을 만들고자 한다면 이 데이터 로더를 반드시 정의해야 합니다.

- 데이터로더는 학습 때 데이터를 배치(batch) 단위로 모델에 밀어 넣어주는 역할. 전체 데이터 가운데 일부 인스턴스를 뽑아(sample) 배치를 구성. 데이터셋(dataset)은 데이터 로더의 구성 요소 가운데 하나. 데이터셋은 여러 인스턴스(문서+레이블)를 보유하고 있다.

- 데이터 로더가 배치를 만들 때 인스턴스를 뽑는 방식은 파이토치 사용자가 자유롭게 정할 수 있음.

- 배치는 그 모양이 고정적어야 할 때가 많습니다. 다시 말해 동일한 배치에 있는 문장들의 토큰(input_ids) 개수가 같아야 한다.

- 이같이 배치의 모양 등을 정비해 모델의 최종 입력으로 만들어주는 과정을 컬레이트(collate)라고 함

- 컬레이트 과정에는 파이썬 리스트(list)에서 파이토치 텐서(tensor)로의 변환 등 자료형 변환도 포함. 컬레이트 수행 방식 역시 파이토치 사용자가 자유롭게 구성할 수 있다.

from torch.utils.data import DataLoader, RandomSampler

from ratsnlp.nlpbook.classification import NsmcCorpus, ClassificationDataset

corpus = NsmcCorpus()

train_dataset = ClassificationDataset(

args=args,

corpus=corpus,

tokenizer=tokenizer,

mode="train",

)

train_dataloader = DataLoader(

train_dataset,

batch_size=args.batch_size,

sampler=RandomSampler(train_dataset, replacement=False),

collate_fn=nlpbook.data_collator,

drop_last=False,

num_workers=args.cpu_workers,

)6. Task 정의

- PyTorch Lightning Model 사용

- PyTorch Lightning: 딥러닝 모델을 학습할 때 반복적인 내용을 대신 수행해줘 사용자가 모델 구축에만 신경쓸 수 있도록 돕는 라이브러리

- 최적화(optimization)란 특정 조건에서 어떤 값이 최대나 최소가 되도록 하는 과정을 가리킴.

- 이를 위해 옵티마이저(optimizer), 러닝 레이트 스케줄러(learning rate scheduler) 등을 정의해 둡니다.

- 모델 학습은 배치 단위로 이뤄집니다. 배치를 모델에 입력한 뒤 모델 출력을 정답과 비교해 차이를 계산합니다. 이후 그 차이를 최소화하는 방향으로 모델을 업데이트 한다.

- 이러한 일련의 과정을 스텝(step)이라고 한다.

7. 모델 학습하기

- 트레이너(Trainer)는 파이토치 라이트닝에서 제공하는 객체로 실제 학습을 수행

from ratsnlp.nlpbook.classification import ClassificationTask

task = ClassificationTask(model, args)

trainer = nlpbook.get_trainer(args)

trainer.fit(

task,

train_dataloader=train_dataloader,

)'📝 NLP (자연어처리) > 📕 Natural Language Processing' 카테고리의 다른 글

| [NLP] Seq2Seq, Encoder & Decoder (0) | 2024.01.19 |

|---|---|

| [NLP] Pre-Trained Language Model - 미리 학습된 언어모델 (0) | 2024.01.18 |

| [NLP} Tokenization - 토큰화하기 (0) | 2024.01.18 |

| [NLP] Building a vocabulary set - 어휘 집합 구축하기 (0) | 2024.01.18 |

| [NLP] Tokenization - 토큰화란? (0) | 2024.01.16 |