이번엔 t-SNE (t-Distributed Stochastic Neighbor Embedding)에 데하여 한번 알아보겠습니다.

t-SNE는 고차원 데이터를 저차원 공간에 효과적으로 시각화하기 위해 개발된 비선형 차원 축소 기법입니다. 주로 고차원 데이터의 클러스터링 구조를 시각적으로 표현하는 데 사용되며, 데이터 포인트 간의 지역적 유사성을 보존하는 데 강력한 성능을 발휘합니다.

t-SNE의 특징

t-SNE의 특징은 어떠한 점들이 있을까요?

- 비선형 차원 축소: t-SNE는 고차원 데이터의 비선형 구조를 저차원에서 보존하는 데 특화되어 있습니다. 이는 데이터가 선형적인 구조를 가지지 않는 경우에도 적합한 결과를 제공합니다.

- 지역적 유사성 보존: t-SNE는 데이터 포인트 간의 지역적 유사성을 유지하는 데 중점을 둡니다. 이는 클러스터 내의 데이터 포인트들이 저차원 공간에서도 가깝게 배치되도록 합니다.

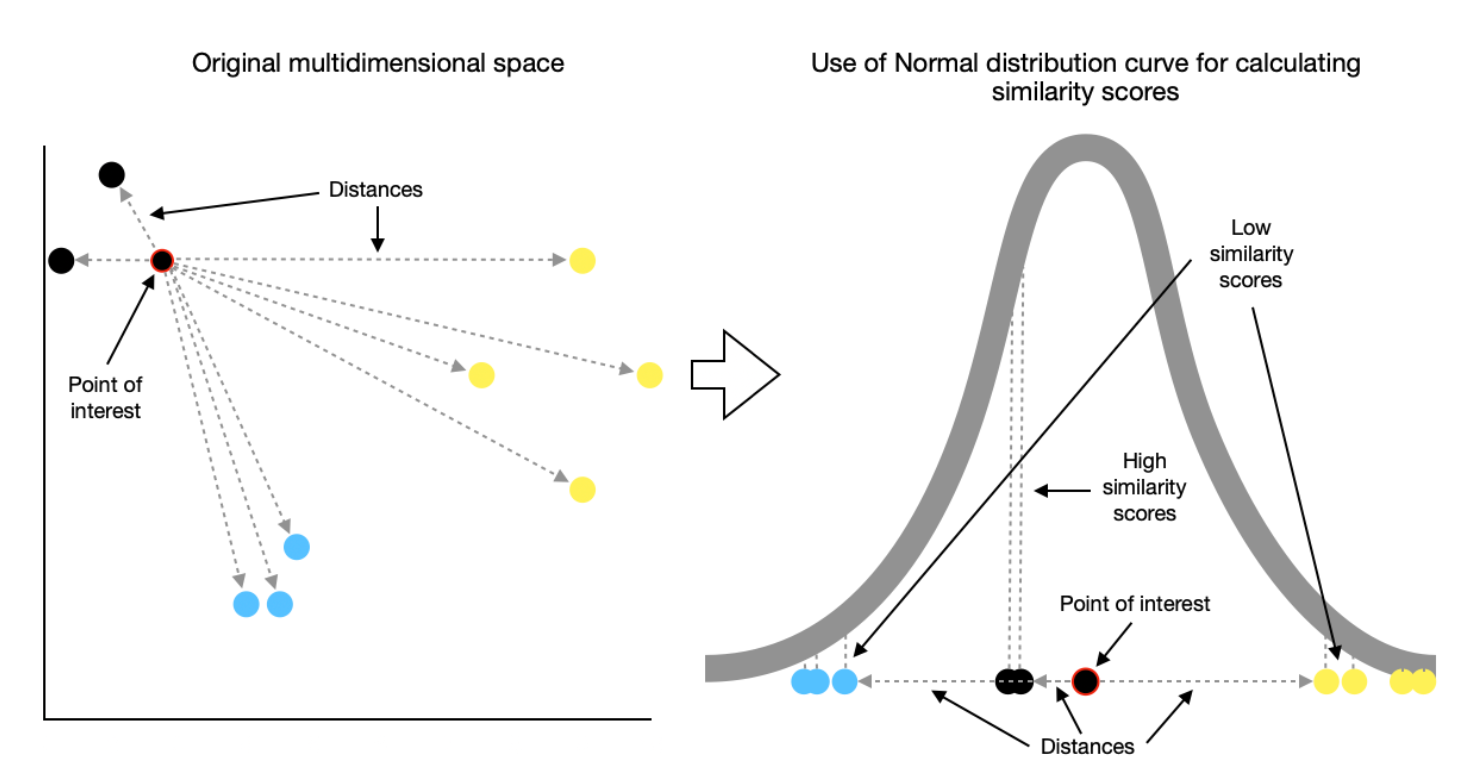

- 확률 기반 접근: t-SNE는 데이터 포인트 간의 거리 정보를 확률로 변환하여 차원을 축소합니다. 이는 고차원 공간에서 가까운 데이터 포인트들이 저차원 공간에서도 가까이 배치되도록 유도합니다.

- KL 발산 최소화: t-SNE는 고차원과 저차원 간의 확률 분포 차이를 KL 발산(Kullback-Leibler Divergence)을 통해 최소화하여 최적의 저차원 임베딩을 탐색합니다. 이를 통해 데이터의 구조를 효과적으로 보존합니다.

t-SNE의 기본 원리

t-SNE은 3가지의 기본 원리가 있습니다.

고차원 공간에서 거리 계산 및 확률 변환

- 각 데이터 포인트 간의 거리를 계산하고, 이 거리를 확률로 변환합니다. 이를 통해 가까운 이웃 간의 유사성을 확률로 표현합니다.

저차원 공간에서 거리 계산 및 확률 변환

- 초기화된 저차원 공간에서의 거리도 확률로 변환하여, 고차원 공간의 확률과 비교합니다. 저차원 공간에서의 배치는 이 확률을 바탕으로 조정됩니다.

확률 분포 간의 차이 최소화

- 고차원 공간과 저차원 공간의 확률 분포 간의 차이를 KL 발산을 사용해 최소화합니다. 이 과정에서 저차원 공간에서의 데이터 포인트 배치가 최적화됩니다.

t-SNE의 장, 단점 & 개선 방법

t-SNE의 장점

- 고차원 데이터 시각화: t-SNE는 고차원 데이터의 복잡한 구조를 2차원 또는 3차원으로 효과적으로 시각화할 수 있습니다. 이를 통해 데이터의 클러스터 구조를 직관적으로 이해할 수 있습니다.

- 지역적 유사성 보존: 데이터 포인트 간의 지역적 유사성을 잘 유지하여, 저차원 공간에서 클러스터 구조를 명확하게 표현할 수 있습니다.

- 다양한 데이터 유형 처리: t-SNE는 이미지, 텍스트, 유전자 데이터 등 다양한 데이터 유형에 적용 가능하며, 각 데이터의 특성을 잘 반영합니다.

t-SNE의 단점

- 시간 복잡도: t-SNE는 큰 데이터셋에서는 계산 비용이 높아 실행 시간이 오래 걸릴 수 있습니다. 특히 데이터셋의 크기가 커질수록 이 문제가 심각해집니다.

- 매개변수 민감성: t-SNE는 perplexity와 학습률과 같은 매개변수에 민감합니다. 적절한 매개변수를 찾기 위해 여러 번의 실험이 필요할 수 있습니다.

- 해석의 어려움: t-SNE의 결과는 저차원 공간에서 어떻게 해석되어야 하는지 명확하지 않을 수 있습니다. 특히, 저차원 임베딩의 의미를 이해하는 데 어려움이 있을 수 있습니다.

t-SNE의 개선 방법

- 매개변수 최적화

- perplexity, 학습률 등의 매개변수를 최적화하여 성능을 향상시킬 수 있습니다. 일반적으로 perplexity는 데이터 포인트 수의 1/10에서 1/5 사이의 값을 사용하는 것이 추천됩니다.

- 대규모 데이터셋 처리

- Barnes-Hut t-SNE와 같은 변형 알고리즘을 사용하여 대규모 데이터셋에서도 효율적으로 작동할 수 있습니다. 이 변형은 t-SNE의 계산 복잡성을 줄이기 위해 고안되었습니다.

- 차원 축소 전 전처리

- 노이즈를 제거하거나, 사전에 PCA와 같은 기법으로 차원을 축소한 후 t-SNE를 적용하면 성능이 향상될 가능성이 높습니다. 이는 t-SNE가 처리해야 할 데이터의 복잡성을 줄이는 데 도움을 줍니다.

t-SNE Example Code

# 필요한 라이브러리 임포트

import numpy as np

import pandas as pd

from sklearn.datasets import load_iris

from sklearn.preprocessing import StandardScaler

from sklearn.manifold import TSNE

import matplotlib.pyplot as plt

# Iris 데이터셋 로드

iris = load_iris()

X = iris.data

y = iris.target

# 데이터 표준화

scaler = StandardScaler()

X_scaled = scaler.fit_transform(X)# t-SNE 적용

tsne = TSNE(n_components=2, random_state=42)

X_tsne = tsne.fit_transform(X_scaled)

# t-SNE 결과 시각화

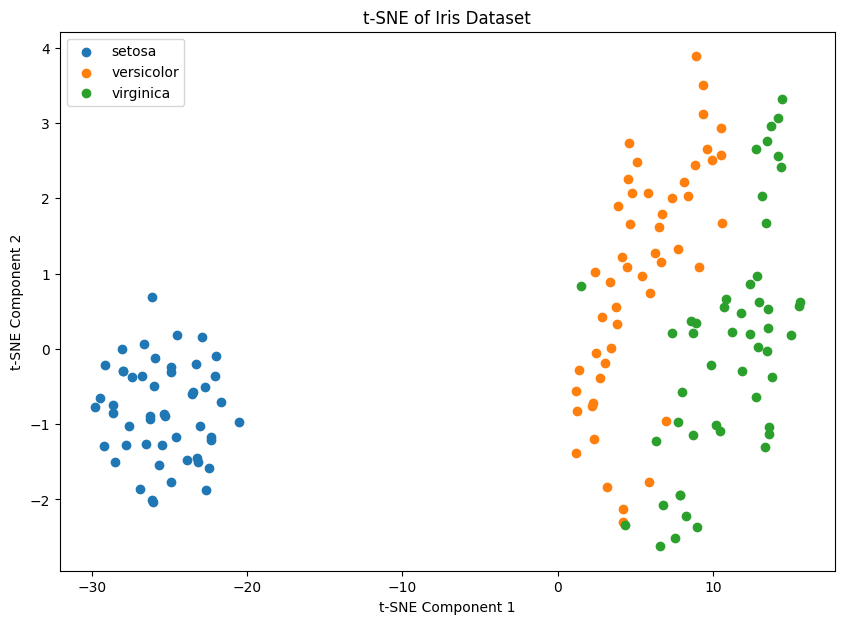

plt.figure(figsize=(10, 7))

for target in np.unique(y):

plt.scatter(X_tsne[y == target, 0], X_tsne[y == target, 1], label=iris.target_names[target])

plt.xlabel('t-SNE Component 1')

plt.ylabel('t-SNE Component 2')

plt.title('t-SNE of Iris Dataset')

plt.legend()

plt.show()

'📈 Data Engineering > 📇 Machine Learning' 카테고리의 다른 글

| [ML] Emsemble Methods (앙상블 기법) (0) | 2024.08.23 |

|---|---|

| [ML] 연관 규칙 학습 (Association Rule Learning) (0) | 2024.08.22 |

| [ML] Isomap (아이소맵) (0) | 2024.08.20 |

| [ML] Principal Component Analysis (PCA - 주성분 분석) (0) | 2024.08.18 |

| [ML] DBSCAN (Density-Based Spatial Clustering of Applications with Noise) (0) | 2024.08.18 |