데이터의 종류와 속성

데이터의 종류와 속성에 데하여 알아보겠습니다.

정량적 데이터 (Quantitative Data)

- 정량적 데이터는 수치로 표현되는 데이터로, 양적 측정이 가능한 데이터입니다.

- 예시: 나이, 소득, 판매량 등의 데이터입니다.

- 특징:

- 수치 데이터를 통해 통계 분석과 예측 모델링이 가능힙니다.

- 수치형 데이터와 범주형 데이터, 두 가지 주요 형태로 나뉩니다.

정성적 데이터 (Qualitative Data)

- 수치가 아닌 의미와 특성으로 분류되는 데이터입니다.

- 예시: 댓글, 동영상, 음성 등.

- 특징:

- 텍스트, 이미지, 동영상 등 다양한 형식을 가질 수 있습니다.

- 정량적 데이터와 달리 통계 분석이 어렵습니다.

- 용도: 텍스트 분석, 감정 분석, 콘텐츠 분석 등에 사용됩니다.

수치형 데이터 (Numerical Data)

- 수치형 데이터는 값의 범위가 무한하고, 측정 가능한 데이터입니다.

- 예시: 온도, 무게, 거리 등의 데이터입니다.

- 특징:

- 연속형 데이터 (Continuous Data): 값이 특정 범위 내에서 무한한 값을 가질 수 있는 데이터입니다. 예: 온도, 무게.

- 이산형 데이터 (Discrete Data): 값이 특정 범위 내에서 유한한 값을 가지는 데이터입니다. 예: 학생 수, 판매된 제품 개수.

- 용도: 연속 변수에서의 경향성 분석, 변수들 간의 상관관계를 파악하는데 사용됩니다.

범주형 데이터 (Categorical Data)

- 제한된 범위의 값을 가지며, 일반적으로 레이블 형태로 제공되는 데이터입니다.

- 예시: 결혼 상태, 학력, 직업 유형 등의 데이터입니다.

- 특징:

- 명목형 데이터 (Nominal Data): 순서가 없는 범주형 데이터. 예: 성별, 국가.

- 순위형 데이터 (Ordinal Data): 순서가 있는 범주형 데이터. 예: 교육 수준, 고객 만족도 평가.

- 용도: 인구 통계학적 분석, 고객 세분화, 카테고리 간의 비교와 분석을 하는 용도로 사용됩니다.

데이터 품질의 요소

데이터 품질의 요소는 정확성, 완전성, 일관성, 타당성, 이렇게 4가지가 있습니다. 하나하나 설명해 보겠습니다.

- 정확성 (Accuracy)

- 데이터가 실제 값과 얼마나 일치하는지를 나타내는 지표입니다. 정확한 데이터는 올바른 결정을 내리는 데 필수적입니다.

- 예시: 고객의 나이를 기록하는 데이터베이스에서 나이가 30세인 고객을 40세로 기록하면 데이터의 정확성이 떨어집니다.

- 완전성 (Completeness)

- 필요한 모든 데이터가 빠짐없이 존재하는지를 나타냅니다. 데이터가 불완전하면 분석 결과에 왜곡이 생길 수 있습니다.

- 예시: 고객 연락처 데이터베이스에서 일부 고객의 이메일 주소가 누락된 경우, 데이터의 완전성이 떨어집니다.

- 일관성 (Consistency)

- 데이터가 여러 데이터베이스나 데이터셋에서 동일하게 유지되는지를 나타냅니다. 일관되지 않은 데이터는 신뢰할 수 없는 결과를 초래할 수 있습니다.

- 예시: 제품의 가격이 여러 데이터베이스에서 다르게 기록되어 있다면 데이터의 일관성이 떨어집니다.

- 타당성 (Validity)

- 데이터가 특정 기준이나 규칙을 충족하는지를 나타냅니다. 타당한 데이터는 특정 형식이나 범위를 벗어나지 않습니다.

- 예시: 고객의 나이를 기록하는 필드에 음수가 입력된 경우, 데이터의 타당성이 떨어집니다.

데이터 전처리의 중요성

높은 품질의 데이터는 분석 결과의 신뢰성을 보장합니다.

- 데이터 전처리는 데이터를 분석하기 전에 데이터를 정제하고 준비하는 과정입니다.

- 데이터의 품질이 높을수록 분석 결과의 신뢰성이 높아집니다.

- 예시: 결측치와 이상치가 포함된 데이터를 분석하면, 결과가 왜곡될 수 있습니다.

전처리 과정

- 결측치가 있는 데이터를 그대로 분석하면 결과가 왜곡될 수 있습니다.

- 결측치는 제거하거나 적절한 값으로 대체해야 합니다.

# 결측치 제거

df.dropna(inplace=True)

# 결측치 대체

df.fillna(df.mean(), inplace=True)

이상치 탐지 및 제거

- 이상치는 데이터의 일반적인 패턴에서 벗어난 값으로, 이를 제거하지 않으면 분석 결과에 큰 영향을 미칠 수 있습니다.

- Example: IQR 방법을 사용한 이상치 제거

# IQR 방법을 사용한 이상치 제거

Q1 = df.quantile(0.25)

Q3 = df.quantile(0.75)

IQR = Q3 - Q1

df = df[~((df < (Q1 - 1.5 * IQR)) | (df > (Q3 + 1.5 * IQR))).any(axis=1)]

데이터 정규화

- 데이터의 범위를 일정하게 조정하여 모델 학습을 용이하게 합니다.

- 데이터 정규화는 데이터의 스케일을 통일시켜 분석 결과의 신뢰성을 높입니다.

# 예시 코드

from sklearn.preprocessing import StandardScaler

scaler = StandardScaler()

df_scaled = scaler.fit_transform(df)

비즈니스 인사이트의 정확성과 직결

- 정확한 데이터 전처리는 비즈니스 인사이트의 정확성과 직결됩니다.

- 잘못된 데이터로 인한 분석 결과는 잘못된 의사결정을 초래할 수 있습니다.

- 예시: 고객 세분화 분석을 위해 데이터를 정제하고 전처리하지 않으면, 잘못된 고객 그룹이 도출될 수 있으며, 이는 마케팅 전략의 실패로 이어질 수 있습니다.

데이터 탐색 (Exploratory Data Analysis, EDA)

데이터 탐색? 즉, EDA라는 말은 무엇일까요? 한번 알아보겠습니다.

- 탐색적 데이터 분석(Exploratory Data Analysis, EDA)은 데이터 분석 초기 단계에서 수행되는 중요한 과정으로, 데이터를 시각화하고 요약하여 데이터의 중요한 특성과 패턴을 발견하는 과정입니다.

- 또한 데이터의 구조, 예외, 패턴, 및 기초 통계적 요약을 제공하는 과정입니다.

- 이를 통해, 모델링 방향을 설정하는 데 기여하며, 데이터에 대한 이해도를 향상시키는 과정입니다.

EDA의 주요 목적

그러면 왜 탐색적 데이터 분석(Exploratory Data Analysis, EDA)를 해야하느냐?

탐색적 데이터 분석(Exploratory Data Analysis, EDA)를 해야하는 주요 목적에 데하여 알아보겠습니다.

- 데이터의 구조 이해

- 데이터의 전반적인 구조를 파악하고, 변수 간의 관계를 이해합니다.

- 데이터의 분포, 범위, 중앙값, 평균 등의 기초 통계치를 통해 데이터를 요약합니다.

- 예외 및 이상치 탐지

- 데이터셋 내의 예외값이나 이상치를 탐지하여 분석 과정에서 발생할 수 있는 문제를 미리 발견합니다.

- 이를 통해 이상치를 제거하거나 처리하는 전략을 수립할 수 있습니다.

- 패턴 발견

- 데이터 내의 숨겨진 패턴이나 트렌드를 발견합니다.

- 변수 간의 상관관계, 시계열 데이터의 추세 등을 파악하여 데이터의 특성을 이해합니다.

- 기초 통계적 요약 제공

- 데이터의 기초 통계량을 계산하여 요약합니다.

- 평균, 중간값, 최빈값, 분산, 표준편차 등 주요 통계치를 통해 데이터를 요약하고 설명합니다.

- 데이터에 대한 이해도 향상

- 데이터에 대한 전반적인 이해도를 높여 이후 분석 과정에서 데이터에 대한 직관을 제공합니다.

- 데이터의 성격을 파악하고, 이를 바탕으로 적절한 분석 기법을 선택할 수 있습니다.

- 모델링 방향 설정

- 데이터 분석 및 모델링의 방향을 설정하는 데 중요한 역할을 합니다.

- EDA를 통해 발견한 패턴과 통계적 특성을 바탕으로 모델링 전략을 수립하고, 모델의 성능을 높일 수 있습니다.

EDA 중요성

탐색적 데이터 분석(Exploratory Data Analysis, EDA)의 중요성에 데하여 설명해보겠습니다.

- 탐색적 데이터 분석(Exploratory Data Analysis, EDA)는 데이터 분석의 방향과 품질을 결정지을 수 있는 핵심 단계입니다.

- 잠재적 문제를 사전에 파악하고 수정할 기회를 제공하며, 데이터의 질과 구조를 이해하여 데이터 분석 결과의 정확성을 향상시키기 위한 목적을 가지고 있습니다. 아래에 내용에 더 자세히 설명해 놓았습니다.

- 데이터 분석의 방향과 품질 결정

- EDA는 데이터 분석 프로젝트의 초기 단계에서 수행되며, 데이터 분석의 방향과 품질을 결정짓는 핵심 단계입니다.

- 이 단계에서 데이터의 주요 특성을 파악하고, 분석 목표를 설정하는 데 중요한 정보를 제공합니다.

- 예시: 데이터 분포와 변수를 파악한 후, 적절한 분석 기법을 선택하고 적용할 수 있습니다.

- 잠재적 문제 사전 파악 및 수정 기회 제공

- EDA를 통해 데이터셋의 결측치, 이상치, 데이터 입력 오류 등 잠재적인 문제를 사전에 발견하고 수정할 수 있습니다.

- 이를 통해 데이터의 신뢰성을 높이고, 분석 결과의 정확성을 보장할 수 있습니다.

- 예시: 결측치나 이상치를 발견하고 이를 처리하여 데이터의 질을 개선할 수 있습니다.

- 데이터의 질과 구조 이해를 통한 정확성 향상

- EDA를 통해 데이터의 질과 구조를 깊이 이해할 수 있으며, 이를 통해 데이터 분석 결과의 정확성을 향상시킬 수 있습니다.

- 데이터의 패턴, 분포, 관계 등을 파악하여 보다 신뢰성 있는 분석을 수행할 수 있습니다.

- 예시: 데이터의 분포를 이해하고, 분석에 적합한 데이터 전처리 방법을 선택할 수 있습니다.

데이터 분석에서 EDA의 역할

데이터 분석에서의 EDA의 역할에 데하여 설명을 해보겠습니다.

- EDA 과정에서 데이터의 결측치, 이상치 및 분포를 파악하여 데이터 정제 및 전처리 계획을 수립합니다.

- 또한 관련성이 높은 변수를 식별하여 더 효과적인 머신러닝 & 딥러닝 모델을 구축할 수 있도록 지원합니다.

1. 데이터의 결측치, 이상치 및 분포 파악

- EDA는 데이터의 결측치, 이상치 및 분포를 파악하여 데이터 정제 및 전처리 계획을 수립하는 데 도움을 줍니다.

- 이를 통해 데이터의 품질을 높이고, 분석 과정에서 발생할 수 있는 오류를 줄일 수 있습니다.

- Example Code (예시 코드)

# 결측치 확인

missing_values = data.isnull().sum()

print(missing_values)

# 이상치 탐지 (박스플롯 사용)

plt.boxplot(data['column_name'])

plt.title('Box Plot of Column Name')

plt.ylabel('Value')

plt.show()

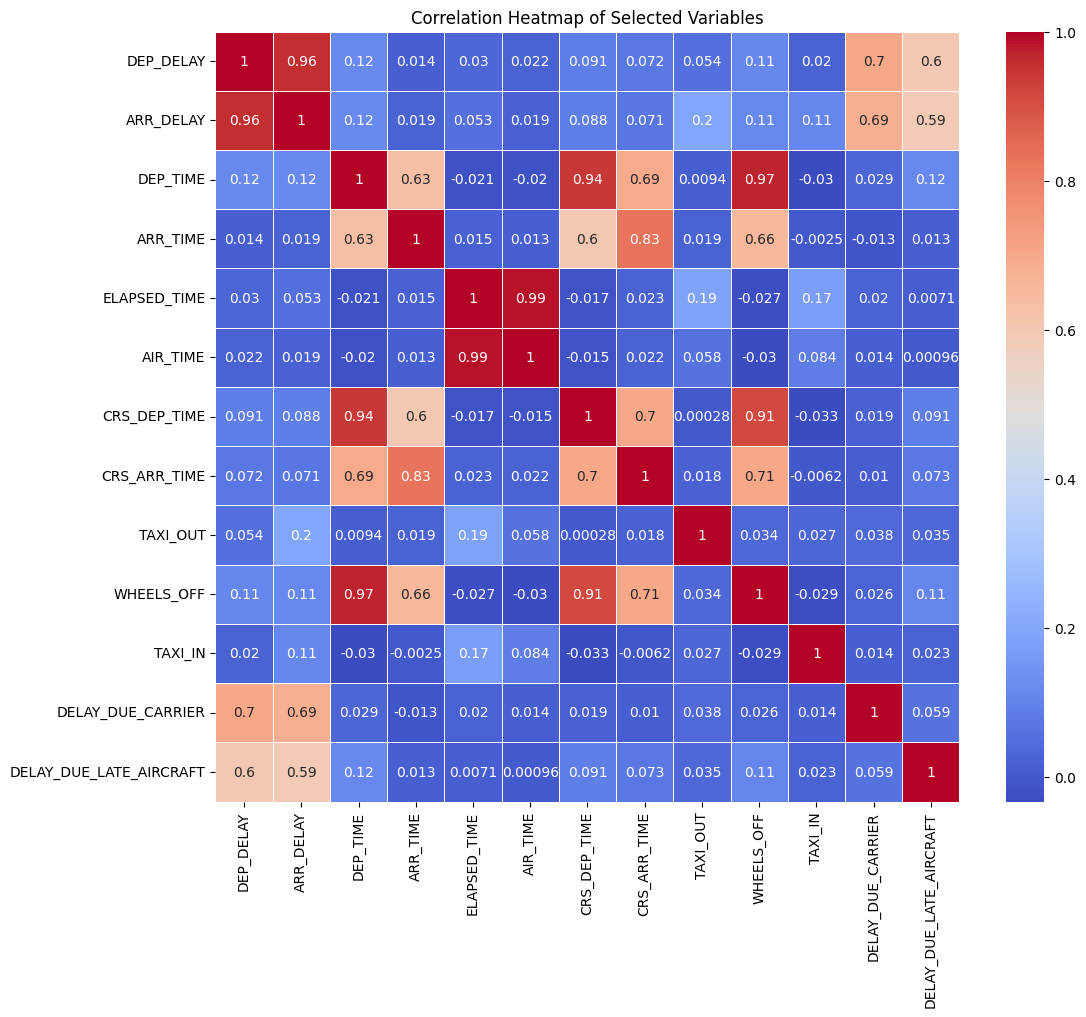

2. 관련성이 높은 변수 식별

- EDA는 데이터 내의 변수들 간의 관계를 파악하여, 관련성이 높은 변수를 식별하는 데 도움을 줍니다.

- 이를 통해 더 효과적인 모델을 구축할 수 있으며, 분석의 정확성과 효율성을 높일 수 있습니다.

- Example Code (예시 코드)

# 상관 행렬을 통한 변수 간의 상관관계 분석

correlation_matrix = data.corr()

print(correlation_matrix)

# 히트맵 시각화

import seaborn as sns

sns.heatmap(correlation_matrix, annot=True, cmap='coolwarm')

plt.title('Correlation Matrix Heatmap')

plt.show()주요 데이터 시각화 기법

데이터 시각화를 하여 데이터의 분포와 관계를 시각적으로 표현합니다.

- 주요 기법으로는 히스토그램, 박스 플롯, 산점도, 히트맵, 파이 차트가 있습니다.

히스토그램 (Histogram)

- 데이터의 분포를 나타내는 그래프로, 데이터를 일정한 구간(bin)으로 나누어 각 구간에 속하는 데이터의 빈도를 시각화합니다.

- 용도: 데이터의 분포 형태, 중앙값, 변동성 등을 파악할 때 사용합니다.

import matplotlib.pyplot as plt

data = [1, 2, 2, 3, 3, 3, 4, 4, 4, 4]

plt.hist(data, bins=5)

plt.title('Histogram')

plt.xlabel('Value')

plt.ylabel('Frequency')

plt.show()

박스 플롯 (Box Plot)

- 데이터의 중앙값, 사분위수, 이상치를 시각화하는 그래프입니다.

- 용도: 데이터의 분포, 변동성, 이상치를 파악할 때 유용합니다.

data = [1, 2, 2, 3, 3, 3, 4, 4, 4, 4]

plt.boxplot(data)

plt.title('Box Plot')

plt.ylabel('Value')

plt.show()

산점도 (Scatter Plot)

- 두 변수 간의 관계를 시각화하는 그래프로, 각 데이터를 점으로 표시합니다.

- 용도: 변수 간의 상관관계, 패턴, 이상치를 파악할 때 사용합니다.

x = [1, 2, 3, 4, 5]

y = [2, 3, 5, 7, 11]

plt.scatter(x, y)

plt.title('Scatter Plot')

plt.xlabel('X')

plt.ylabel('Y')

plt.show()

히트맵 (Heatmap)

- 값의 크기를 색상으로 표현하여 데이터를 시각화하는 방법입니다.

- 용도: 변수 간의 상관관계, 패턴을 시각적으로 표현할 때 유용합니다.

import seaborn as sns

import numpy as np

data = np.random.rand(10, 12)

sns.heatmap(data, annot=True, cmap='coolwarm')

plt.title('Heatmap')

plt.show()

파이 차트 (Pie Chart)

- 전체 데이터에서 각 부분이 차지하는 비율을 시각화하는 원형 그래프입니다.

- 용도: 카테고리형 데이터의 구성 비율을 파악할 때 사용합니다.

labels = 'A', 'B', 'C', 'D'

sizes = [15, 30, 45, 10]

plt.pie(sizes, labels=labels, autopct='%1.1f%%', startangle=140)

plt.title('Pie Chart')

plt.show()

기술 통계 (Descriptive Statistics)

기술 통계는 데이터의 통계적 수치를 계산하여 데이터의 경향을 요약하고 설명하는 데 사용됩니다.

이는 데이터를 이해하고 요약하는 데 중요한 역할을 하며, 데이터 분석의 초기 단계에서 자주 사용됩니다.

- 3가지 통계 방법인 중심 경향 측정, 분산도 측정, 요약 통계에 데하여 설명을 해보겠습니다.

중심 경향 측정 (Measures of Central Tendency)

평균 (Mean)

- 데이터의 모든 값을 더한 후 데이터의 개수로 나눈 값입니다.

- 계산 방법 코드

mean_value = data['column_name'].mean()- 예시

import pandas as pd

data = pd.Series([1, 2, 3, 4, 5])

mean_value = data.mean()

print(f'평균: {mean_value}')중앙값 (Median)

- 데이터셋을 정렬했을 때 중앙에 위치한 값입니다.

- 데이터의 절반이 이 값보다 크고, 나머지 절반은 이 값보다 작습니다.

- 계산 방법 코드

median_value = data['column_name'].median()- 예시

median_value = data.median()

print(f'중앙값: {median_value}')

최빈값 (Mode)

- 데이터셋에서 가장 자주 나타나는 값입니다.

- 계산 방법 코드

mode_value = data['column_name'].mode()[0]- 예시

mode_value = data.mode()[0]

print(f'최빈값: {mode_value}')분산도 측정 (Measures of Dispersion)

분산도 측정은 데이터가 얼마나 넓게 퍼져 있는지를 나타내는 통계적 수치입니다.

이는 데이터의 변동성을 이해하는 데 도움을 줍니다.

표준편차 (Standard Deviation)

- 데이터의 값들이 평균으로부터 얼마나 떨어져 있는지를 나타내는 척도입니다.

- 계산 방법:

std_dev = data['column_name'].std()- 예시 코드

std_dev = data.std()

print(f'표준편차: {std_dev}')

분산 (Variance)

- 데이터의 값들이 평균으로부터 얼마나 떨어져 있는지를 제곱하여 평균한 값입니다. 표준편차의 제곱입니다.

- 계산 방법:

variance_value = data['column_name'].var()- 예시 코드

variance_value = data.var()

print(f'분산: {variance_value}')

범위 (Range)

- 데이터셋에서 가장 큰 값과 가장 작은 값의 차이입니다.

- 계산 방법

range_value = data['column_name'].max() - data['column_name'].min()- 예시 코드

range_value = data.max() - data.min()

print(f'범위: {range_value}')

사분위수 범위 (Interquartile Range, IQR)

- 데이터의 중간 50%를 포함하는 값의 범위로, Q3 (3사분위수)에서 Q1 (1사분위수)을 뺀 값입니다.

- 계산 방법

Q1 = data['column_name'].quantile(0.25)

Q3 = data['column_name'].quantile(0.75)

IQR = Q3 - Q1- 예시 코드

Q1 = data.quantile(0.25)

Q3 = data.quantile(0.75)

IQR = Q3 - Q1

print(f'IQR: {IQR}')요약 통계 (Summary Statistics)

요약 통계는 여러 기술 통계를 종합하여 데이터의 전체적인 경향을 한눈에 파악할 수 있도록 제공합니다.

- 계산 방법

summary_statistics = data['column_name'].describe()- 예시 코드

summary_statistics = data.describe()

print(summary_statistics)다변량 분석

다변량 분석은 여러 변수 간의 관계를 분석하여 인사이트를 도출하는 분석 기법입니다.

이를 통해 데이터의 복잡한 구조를 이해하고, 변수들 간의 상호작용을 파악할 수 있습니다.

주요 다변량 분석 기법

Correlation Analysis (상관 분석)

- 두 변수 간의 관계를 분석하여 상관 계수를 계산하는 기법입니다.

- 상관 계수는 두 변수 간의 선형 관계의 강도와 방향을 나타냅니다.

- 주요 상관 계수:

- 피어슨 상관 계수 (Pearson Correlation Coefficient): 두 변수 간의 선형 관계를 측정합니다.

- 스피어만 상관 계수 (Spearman's Rank Correlation Coefficient): 두 변수의 순위를 기반으로 비선형 관계를 측정합니다.

- 켄달 상관 계수 (Kendall's Tau): 두 변수의 순위를 기반으로 비선형 관계를 측정하며, 순위 간의 일관성을 평가합니다.

- Example Code.

import pandas as pd

from scipy.stats import pearsonr, spearmanr, kendalltau

data = pd.DataFrame({

'x': [1, 2, 3, 4, 5],

'y': [2, 3, 5, 7, 11]

})

# 피어슨 상관 계수

pearson_corr, _ = pearsonr(data['x'], data['y'])

print(f'피어슨 상관 계수: {pearson_corr}')

# 스피어만 상관 계수

spearman_corr, _ = spearmanr(data['x'], data['y'])

print(f'스피어만 상관 계수: {spearman_corr}')

# 켄달 상관 계수

kendall_corr, _ = kendalltau(data['x'], data['y'])

print(f'켄달 상관 계수: {kendall_corr}')

Principal Component Analysis, PCA (주성분 분석)

- 다차원 데이터를 차원을 축소하여 중요한 변수를 추출하는 기법입니다.

- 데이터의 분산을 최대한 보존하면서 차원을 축소하여 데이터를 시각화하거나 모델의 효율성을 높입니다.

- 용도: 데이터의 차원 축소, 시각화, 노이즈 제거, 변수 선택 등에 사용됩니다.

- Example Code.

import pandas as pd

from sklearn.decomposition import PCA

data = pd.DataFrame({

'x1': [1, 2, 3, 4, 5],

'x2': [2, 4, 6, 8, 10],

'x3': [5, 4, 3, 2, 1]

})

pca = PCA(n_components=2)

principal_components = pca.fit_transform(data)

print(principal_components)

Factor Analysis (요인 분석)

- 변수들의 상호 관련성을 소수의 요인(factor)으로 추출하는 기법입니다.

- 요인 분석을 통해 관찰된 변수들을 설명하는 숨겨진 요인을 식별할 수 있습니다.

- 용도: 변수 간의 관계 이해, 데이터 차원 축소, 숨겨진 요인의 식별 등에 사용됩니다.

- Example Code.

import pandas as pd

from sklearn.decomposition import FactorAnalysis

data = pd.DataFrame({

'x1': [1, 2, 3, 4, 5],

'x2': [2, 4, 6, 8, 10],

'x3': [5, 4, 3, 2, 1]

})

fa = FactorAnalysis(n_components=2)

factors = fa.fit_transform(data)

print(factors)'📈 Data Engineering > 📊 Data Analysis' 카테고리의 다른 글

| [Data Analysis] 가설 검정과 A/B Test, 시나리오 (0) | 2024.07.20 |

|---|---|

| [Data Analysis] 기초 통계, 상관 & 인과관계 (0) | 2024.07.18 |

| [Data Analysis] Data Analysis - 데이터 분석 (0) | 2024.07.17 |

| [Data Analysis] 데이터 전처리 (Data Pre-Processing) (0) | 2024.07.12 |

| [Data Analysis] 데이터 수집 (Crawling, Scrapping) (0) | 2024.07.12 |